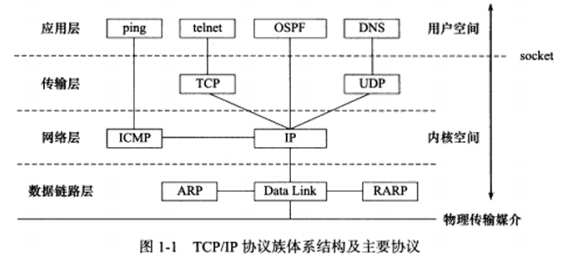

Linux高性能服务器编程 第1章 TCP/IP 协议族 Internet使用的主流协议族是TCP/IP协议族,它是一个分层,多协议的通信体系。本章简单介绍其中几个相关协议: ICMP协议,ARP协议和DNS协议。

1.1 TCP/IP协议族体系结构以及主要协议 四层模型,数据链路层,网络层,传输层和应用层。

a) 数据链路层

实现了网卡接口的网络驱动程序,以处理数据在物理媒介上的传输。隐藏了不同物理网络的细节,为上层协议提供一个统一的接口。

该层的两个常用协议,ARP协议 (Address Resolve Protocol, 地址解析协议) 和 RARP协议 (Reverse Address Resolve Protocol, 逆地址解析协议) 。实现了IP地址和机器物理地址之间的相互转换。

网络层使用IP地址寻址一台机器,而数据链路层使用物理地址寻址一台机器,网络层需要先将目标机器的IP地址转换成其物理地址,才能使用数据链路层提供的服务,这就是ARP协议的用途。

b) 网络层

网络层实现数据包的选路和转发。WAN (Wide Area Network, 广域网) 使用众多分级的路由器来连接分散的主机或 LAN**(Local Area Network, 局域网)**。两台主机一般不是直接相连的,而是通过多个中间节点(路由器)连接的。网络层的任务就是选择这些中间节点。网络层对上层细节隐藏这些细节,在上层看来,通信的双方是直接相连的。

网络层最核心的协议,IP协议 **(Internet Protocol, 因特网协议)**。IP协议根据数据包的目的IP地址来决定如何投递他。如果不能直接发送给目标主机,IP协议为它寻找一个合适的下一跳路由器,并将数据包交给路由器来转发,多次重复这一过程。

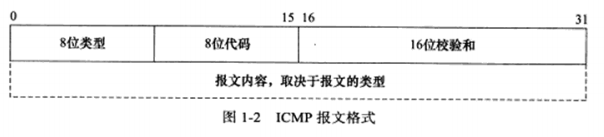

另一个重要协议,ICMP协议 **(Internet Control Message Protocol, 因特网控制报文协议)**。它是IP协议的重要补充,主要用于检测网络连接。

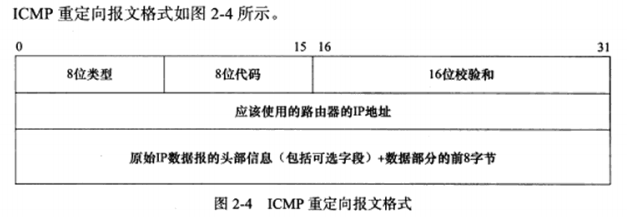

8位类型用于区分报文类型。比如目标不可达(类型值为3),重定向(类型值为5),目标是否可达(类型值为8) 8位代码进一步细分不同条件。16位检验和字段对整个报文进行循环冗余校验,以检验报文在传输过程中是否损坏。

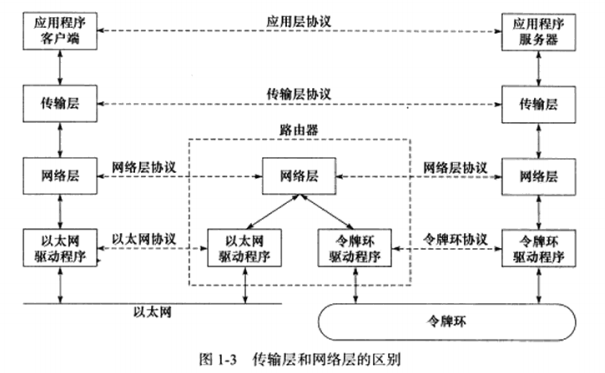

c) 传输层

传输层位两台主机提供端到端的通信。简单来说不考虑IP协议的中转过程了,这些也在网络层中向上隐藏细节了。下图实线箭头表示协议族各层中之间的实体通信,水平虚线表示逻辑通信线路。

传输层主要有三个协议:TCP协议,UDP协议,SCTP协议。本书不讨论SCTP协议,TCP和UDP协议在UNP中已经比较熟悉了。

d) 应用层

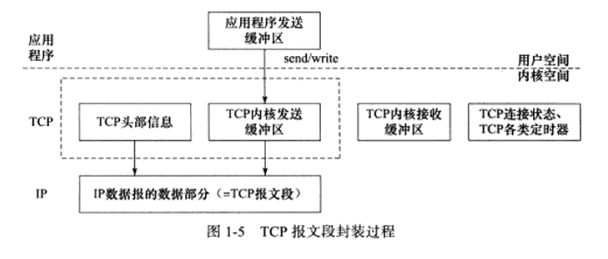

应用层负责处理应用程序的逻辑。前面的三个层处理网络通信细节,这部分稳定高效,因此它们在内核空间中实现。而应用层则在用户空间中实现。

应用层协议很多,图1-1中列举了其中几个:

ping是应用程序,不是协议,他利用ICMP报文检测网络连接。

telnet协议是一种远程登陆协议,它使我们能在本地完成远程任务。

OSPF (Open Shortest Path First, 开放最短路径优先) 协议是一种动态路由更新协议。

DNS (Domain Name Service, 域名服务) 协议提供机器域名到IP地址的转换。

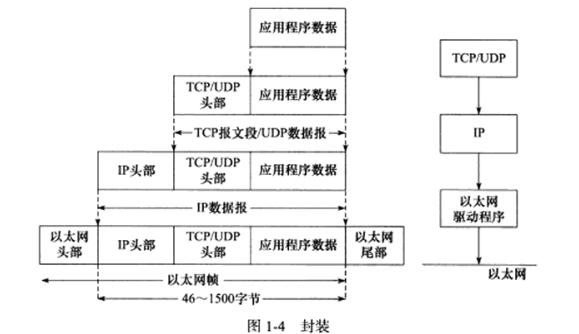

1.2 封装 程序数据在发送到物理网络上之前,将沿着协议栈从上往下传递。每层协议都将在上层数据的基础上加上自己的头部信息,以实现该层的功能呢,这个过程称为封装。

就跟套娃差不多 (

程序数据到 -> TCP/UDP报文段 -> IP数据报 -> 以太网帧

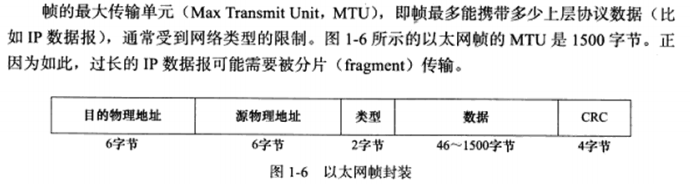

经过数据链路层封装的数据称为帧。传输媒介不同,帧的类型也不同。比如以太网上传输的是以太网帧,而令牌环网络上传输的是令牌环帧。以太网帧的封装格式如下图。类型字段后面讨论,4字节CRC字段对帧的其他部分提供循环冗余校验。

帧才是最终在物理网络上传送的字节序列。至此,封装过程完成。

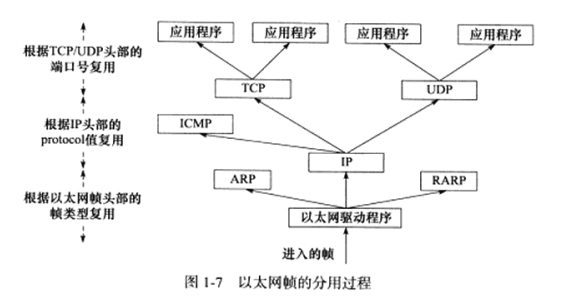

1.3 分用 帧到达目的主机后,将沿着协议族自底向上依次传递。各层协议依次处理帧中本层负责的头部数据,以获取所需信息,并最终将处理后的帧交给目标应用程序。这个过程称为分用。分用时依靠头部信息中的类型字段实现的。

比如拿以太网帧举例说,如果类型字段值为0x800,则帧的数据部分为IP数据报,以太网驱动程序将帧交给IP模块处理;若类型字段值为0X806,则帧的数据部分为ARP请求或应答报文,交给ARP模块来处理;0X835则,RAPA请求或应答,则交给RAPA模块。IP的protocol和TCP/UDP的端口号同理。

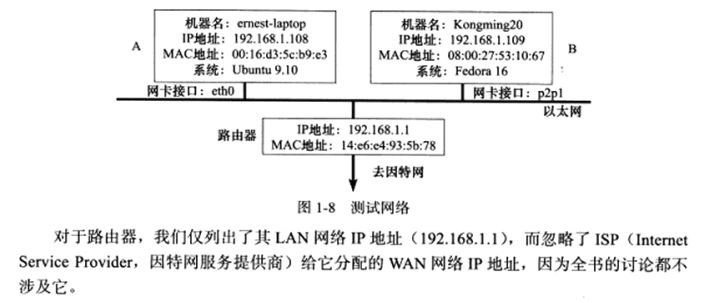

1.4 测试网络 本书实验所用的测试网络。作者编写的多个客户端,服务器程序都是使用该网络来调试和测试的。

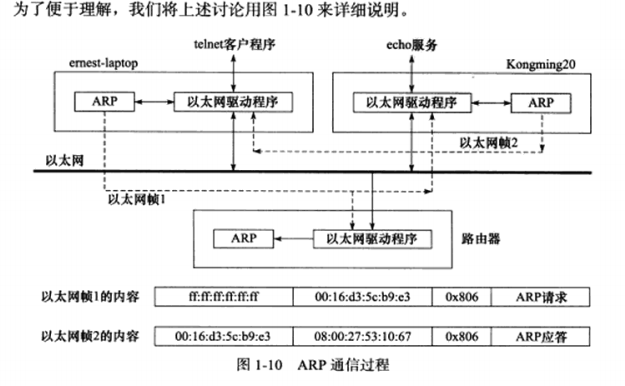

1.5 ARP协议工作原理 ARP协议能实现任意网络层地址到任意物理地址的转换。其工作原理:主机向自己所在的网络广播一个ARP请求,该请求包含目标机器的网络地址。此网络上的其他机器都将收到这个请求,但只有被请求的目标机器会回应一个ARP应答,其中包含自己的物理地址。

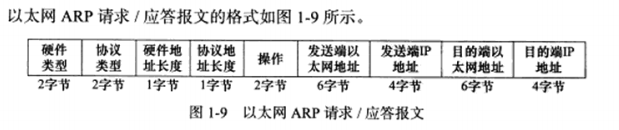

a) 以太网ARP请求/应答报文详解

每个字段的具体值介绍见p9

ARP请求/应答报文的长度为28字节。如果再加上以太网帧头部和尾部的18字节,则一个携带ARP请求/应答报文的以太网帧长度为46字节。

b) ARP高速缓存的查看和修改

通常ARP维护一个高速缓存,其中包含经常访问(比如网关地址)或最近访问的机器的IP地址到物理地址的映射。这样就避免了重复的ARP请求,提高了发送数据包的速度。

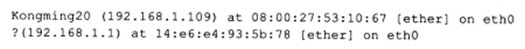

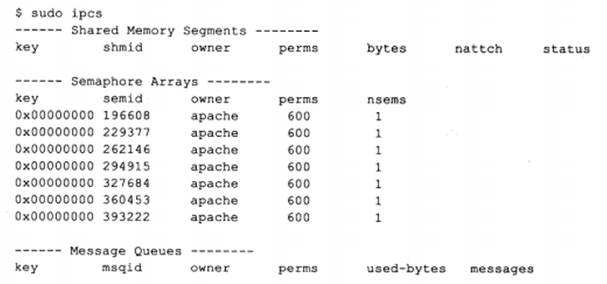

Linxu下可使用arp命令来查看和修改ARP高速缓存,比如ernest-laptop(作者测试网络中的主机)某一时刻的ARP缓存内容如下(使用arp-a命令):

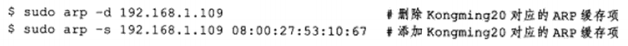

第一项描述的是另一台测试机器Kongming20,第二项描述的是路由器。下面两条命令分别删除和添加一个ARP缓存项:

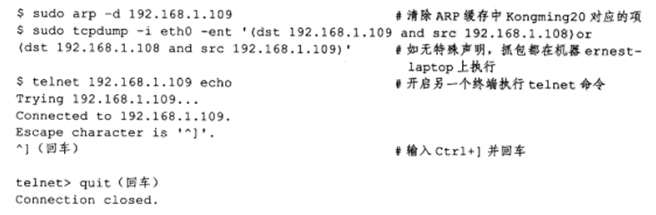

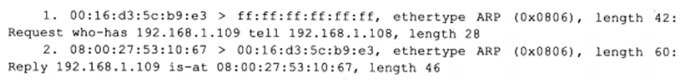

c) 使用tcpdump观察ARP通信过程

在ernest-laptop上执行telnet命令登录Kongming20的echo服务,并用tcpdump抓取这个过程中两台测试机器之间交换的以太网帧。具体操作如下:

在执行telnet命令之前,应先清除ARP缓存中与Kongming20对应的项,否则ARP通信不被执行。ARP通信在TCP连接建立之前就已经完成,我们不关心telnet中的内容,在它建立连接成功后就可以退出。tcpdump中抓取的众多数据包中,只有最靠前的两个和ARP通信有关,将其列出:

第一个数据包,依次看过去,源地址:00:16:d3:5c:b9:e3,目的地址:ff:ff:ff:ff:ff:ff 这是以太网的广播地址,即表示整个LAN,0x0806以太网帧头部类型字段的值 表示ARP模块,长度为42字节;数据部分长度28字节,”Request”表示这是一个ARP请求,”who-has”表示查询对应IP地址。第二个数据包同理

ARP请求和应答实际是从以太网驱动程序发出的,而并非像图中描述的那样从ARP模块直接发送到以太网上,所以用虚线表示。路由器也将接到以太网帧1,因为该帧是一个广播帧。

1.6 DNS工作原理 我们通常使用机器的域名来访问这台机器,而不直接使用IP地址。如何将机器的域名转换成IP地址,这就需要用到域名查询服务。有很多种实现方式,比如NIS **(Network Information Service, 网络信息服务)**,DNS和本地静态文件,本节主要讨论DNS

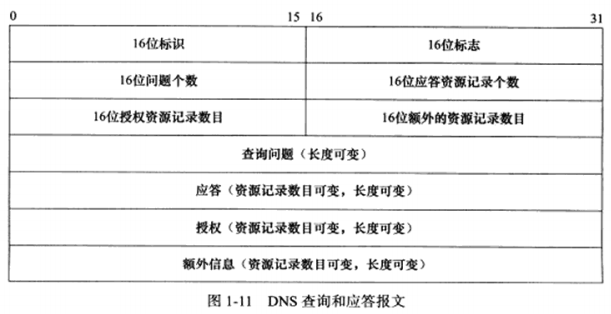

a) DNS查询和应答报文详解

DNS是一套分布式的域名服务系统。每个DNS服务器上存放着大量的机器名和IP地址的映射,并且动态更新的。众多网络客户端使用DNS协议来向DNS服务器查询目标主机的IP地址。DNS查询和应答报文格式如下

具体字段分析,见p13

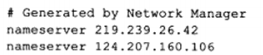

b) Linux下访问DNS服务

我们要访问DNS服务,必须先直到DNS服务器的IP地址。Linux使用/etc/resolvconf文件来存放DNS服务器的IP地址,内容如下

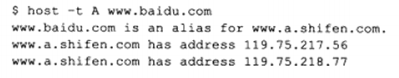

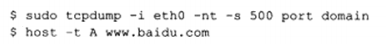

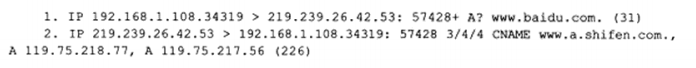

Linux下一个常用的访问DNS服务器的客户端程序是host,比如下面的命令是向首选DNS服务器219.239.26.42查询机器www.baidu.com的IP地址:

c) 使用tcpdump观察DNS通信过程

下面将在ernest-laptop上运行host命令,查询,并使用tcpdump抓取这一过程中的LAN上传输的以太网帧。

使用port domain来过滤数据包,表示只抓取使用domain服务的数据包,输出如下:

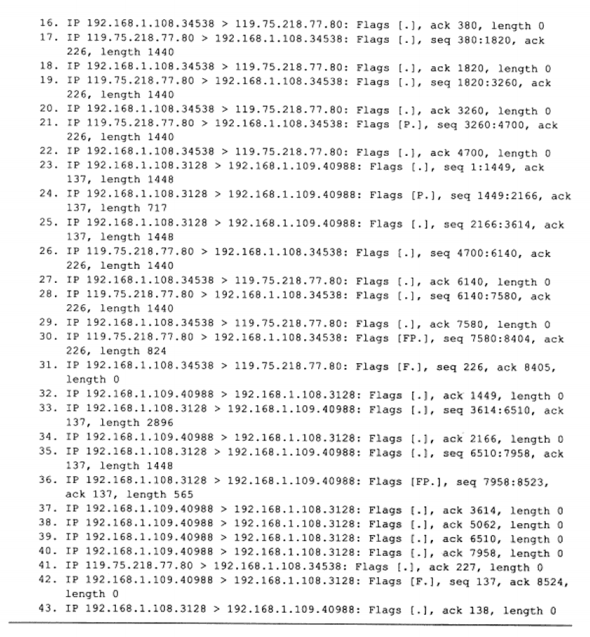

第一个数据包中,数值57428是DNS查询报文的标识值,因此该值也出现在DNS应答报文中。”+”表示启用递归查询标志,”A?”表示使用A类型的查询方式。”www.baidu.com"则是DNS查询问题中的查询名,括号中的数值31是DNS查询报文的长度

第二个数据包中,”3/4/4”表示该报文中包含3个应答资源记录,4个授权资源记录和4个额外信息记录。”CNAMEwww.baidu.com, A 119.75.218.77, A 119.75.217.56”则表示3个应答资源记录的内容,其中CNAME表示机器别名,A表示的记录是IP地址,长度为226字节

1.7 socket 和 TCP/IP 协议族的关系 数据链路层,网络层,传输层协议是在内核中实现的。因此操作系统需要实现一组系统调用,使得应用程序能够访问这些协议提供的服务。实现这组系统调用的API主要有两套:socket和XTI。本书仅讨论socket。

第2章 IP协议详解 IP协议是TCP/IP的核心协议,也是socket网络编程的基础之一。本章从IP头部信息和IP数据报的路由和转发两个方向深入探讨IP协议。

2.1 IP服务的特点 IP协议是TCP/IP协议族的动力,它为上层协议提供无状态,无连接,不可靠的服务。

无状态是指IP通信双方不同步传输数据的状态信息,因此所有IP数据报的发送,传输和接收都是相互独立,没有上下文关系的。这种的服务的最大缺点是无法处理乱序和重复的IP数据报,优点是简单,高效。

无连接是指IP通信双方都不长久地维持对方的任何信息,每次上层协议发送数据时,都必须明确指定对方的IP地址。

不可靠是指IP协议不能保证IP数据报准确地到达接收端。

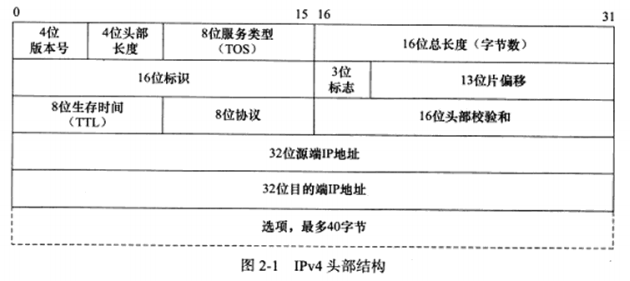

2.2 IPV4头部结构 a) IPV4头部结构

4位版本号指定IP协议的版本,对于IPV4来说是4。其他IPV4协议的扩展版本则有不同版本号。

4位头部长度表示IP头部有多少个32bit字 (4字节) ,4位最大表示15,所以最长60字节

8位服务类型,包括一个3位优先权字段 **(已被忽略)**,4位的TOS字段和1位的保留字段 **(必须置0)**,4位的TOS字段分别表示:最小延时,最大吞吐量,最高可靠性,最小费用。

16位总长度是指整个IP数据报的长度,所以最大65535 **(2^16-1)**,但由于MTU的限制,实际上超过MTU的数据报都将被分片传输。

16位标识唯一地表示主机发送的每一个数据报。其初始值由系统随机生成:每发送一个数据报,其值+1。该值在数据报分片时被复制到每个分片中,因此所有分片拥有相同的标识值。

3位表示字段的第一位保留。第二位DF **(Don’t Fragment)**表示”禁止分片” ,第3位表示MF (More Fragment) “更多分片”。除了数据报的最后一个分片外,其它都要把它置1

13位分片偏移时分片相对原始IP数据报开始处的偏移。

8位生存时间 **(Time To Live, TTL)**,常见的值时64,每经过一个路由,该值减1。为0时,路由器丢弃数据报

8位协议 **(protocol)**用来区分上层协议,类似于TCP的端口,其中ICMP是1,TCP是6,UDP是17。

16位头部校验和,检验IP数据报头部在传输过程中是否损坏。

32位的源端IP地址和目的端IP地址用来表示数据报的发送端和接收端。

IPV4的最后一个字段是可变长的可选信息。最多包含40字节,因为前面部分已经讨论了20字节固定字节,而IP头部最长是60字节。可用的IP选项包括:

记录路由,告诉数据报途径的路由器将IP地址填入头部选项部分,可用来跟踪传递路径。

时间戳,告诉路由器将转发时间填入,测量途径传输的时间。

松散源路由选择,指定一个路由器IP地址列表,数据报必须经过其中的所有路由器。

严格源路由选择,数据报只能经过指定的路由器。

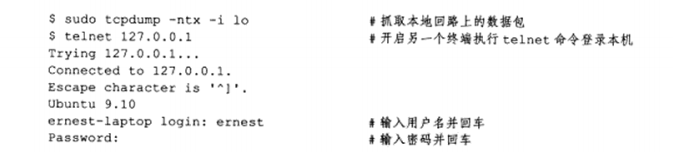

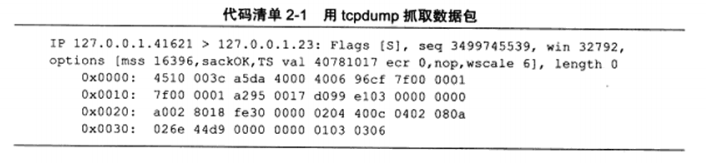

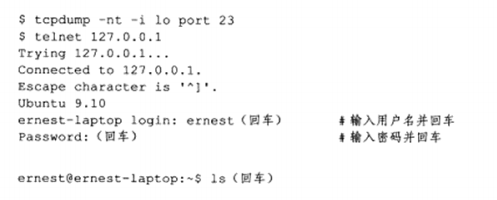

b) 使用tcpdump观察IPV4头部结构

使用测试机器ernest-laptop执行talnet命令登陆本机,使用tcpdump抓取这个过程中交换的数据报。

此时观察tcpdump输出的第一个数据包

由于是本机,所以IP地址是127.0.0.1本地回环。flags,seq,win,options位TCP头部信息,第3章讨论

本次抓包开启了tcpdump的-x选项,使之输出数据报的二进制码,此数据包共60字节,前20字节是IP头部,后40字节是TCP头部,不包含应用程序数据 **(length值为0)**分析结果如下。

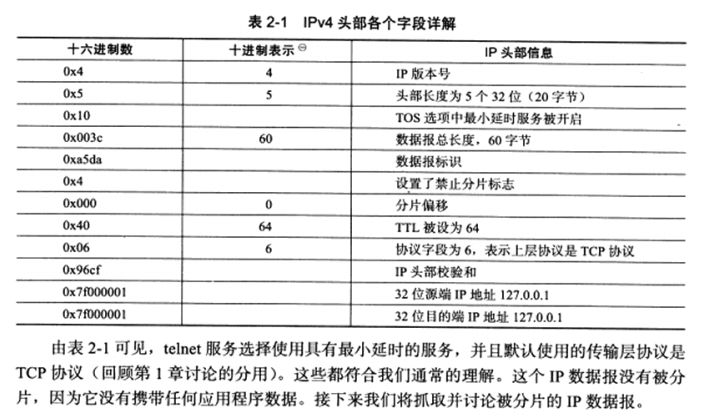

2.3 IP分片 当IP数据报的长度超过帧的MTU时,它将被分片传输。分片可能发生在发送端,也可能发生在中转路由器上,而且可能在传输过程中被多次分片,但只有在最终的目标机器上,这些分片才会被内核中的IP模块重新组装。

和分片关系比较紧密的三个字段:数据报标识,标志和片偏移。每个分片都具有相同的标识值,具有不同的片偏移,且除了最后一个分片外,其他分片设置MF标志。此外,每个分片的IP头部的总长度字段将被设置为该分片的长度。

以太网帧的MTU是1500,因此它可携带的IP数据报的数据部分最多是1480字节 **(IP头部占用20字节)**。考虑用IP数据报封装一个1481的ICMP报文(包括8字节的ICMP头部),分片如下图。

分片为两块,都具有自己的IP头部,且第一个分片设置了MF标志,但ICMP头部只有第一个分片有,因为IP模块重组该ICMP报文的时候只需要一份ICMP头部信息。

ICMP报文的头部长度取决于报文的类型,其变化范围很大。图中8字节原因是后面的例子用到了ping程序,而ping程序使用的ICMP回显和应答报文的头部类型是8字节。

考虑从ernest-laptop来ping机器kongming20,每次发送1473字节来强制引起分片,并使用tcpdump来抓取数据包,操作如下:

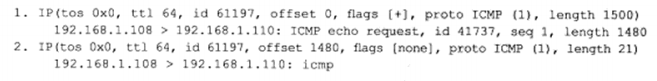

tcpdump输出的两个分片,内容如下:

可以看出它们具有相同的标识值 61197,说明是同一个IP数据报的分片。flags [+] 说明设置了MF标志,而第二个分片不设置。片偏移不同。

2.4 IP路由 IP协议的一个核心任务是数据报的路由,即发送数据报到目标机器的路径。

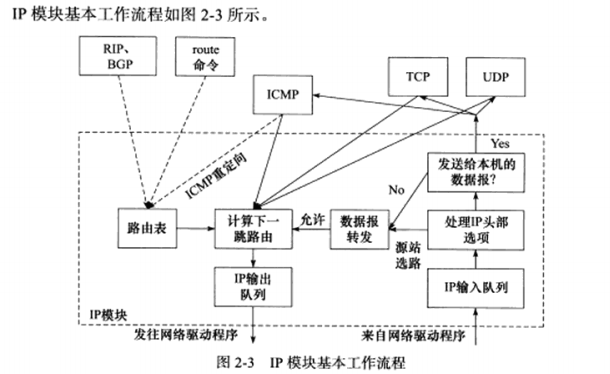

a) IP模块工作流程

当IP模块接收到来自数据链路层的IP数据报时,它首先对该数据报的头部做CRC校验,确认无误后就分析其头部的具体信息 。

如果该IP数据报的头部设置了源站选路选项 (松散源路由选择或严格源路由选择),则IP模块调用 数据报转发子模块 来处理该数据报。如果IP数据报的头部中目的IP地址是本机 的某个IP地址,或者是广播地址,则IP模块根据数据报头部中的协议字段来决定将他派发给上层应用 。如果不是发送给本机的,也交给数据报转发子模块 。

数据报转发子模块 首先检测系统是否允许转发,如果不允许,IP模块将数据报丢弃。如果允许,对该数据执行一些操作,然后将他交给IP数据报输出子模块

IP数据报应该发送至哪一个吓一跳路由,以及经过哪个网卡来发送,就是 IP路由过程 ,即图2-3中的计算下一条路由子模块 。IP模块实现数据报路由的核心数据结构是路由表。

IP输出队列中存放的是所有等待发送的IP数据报,其中除了需要转发的IP数据报外,还包括封装了本机上层数据的IP数据报。

图2-3中的虚线箭头显示了路由表更新过程。

b) 路由机制

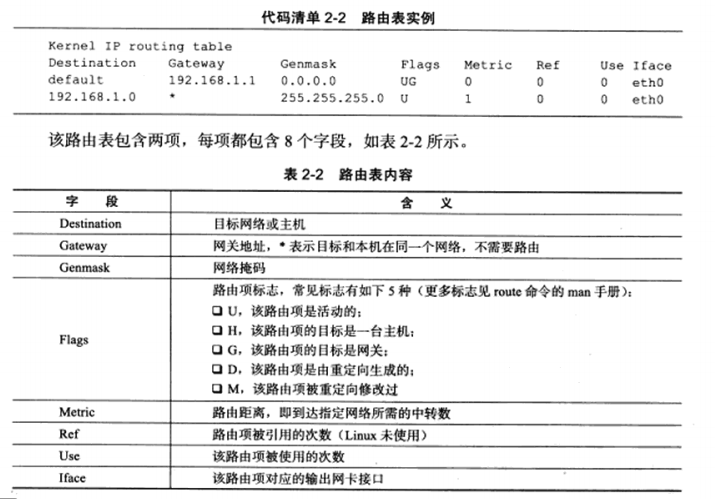

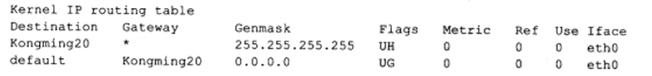

使用route命令或netstat命令查看路由表,测试机器上执行route内容如下:

路由表如何按照IP地址分类?或者说给定数据报的目标IP地址,它将匹配路由表中的哪一项呢?这就是IP的路由机制,分为3个步骤:

查找路由表中和数据报的目标IP地址完全匹配的主机IP地址。如果找到,就使用该路由项,没找到则转步骤2

查找路由表中和数据报的目标IP地址具有相同网路ID的网络IP地址(比如代码清单2-2所示的路由表中的第二项)。如果找到,就使用该路由项:没找到则转步骤3

选择默认路由,这通常意味着数据报的吓一跳路由是网关。

因此,对于测试机器ernest-laptop而言,所有发送到IP地址为192.168.1.*的机器的IP数据报都可以直接发送到目标机器(匹配路由表第二项),而所有访问因特网的请求都通过网关来转发(匹配默认路由项)。

c) 路由表更新

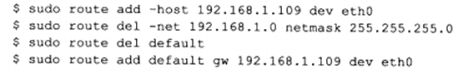

路由表必须能够更新,以反映网络连接的变化,这样IP模块才能够准确,高效地转发数据报。route命令可以修改路由表,如下:

第1行标识添加主机192.168.1.109(机器Kongming20)对应的路由项。这样设置之后,所有从ernest-laptop发送到Kongming20的IP数据报将通过网卡eth0直接发送到目标机器的接收网卡。第2行标识删除网络192.168.1.0对应的路由项,这样除了机器Kongming20外,测试机器无法访问局域网上的任何其他机器。第3行标识删除默认路由项,这样做的后果是无法访问因特网。第4行标识重新设置默认路由项,不过这次其网关是机器Kongming20,修改后的路由表内容如下:

第一个路由项是主机路由项,所以它被设置了”H”标志。设计该路由表的目的是为后文讨论ICMP重定向提供环境。

2.5 IP转发 前文提到,不是发送给本机的IP数据报都将由数据报转发子模块来处理。路由器能执行数据报的转发操作,而主机一般只发送和接收数据报,这是因为主机上/proc/sys/net/ipv4/ip_forward内核参数默认被设置为0。我们可以修改它来使能主机的数据报转发功能:

对于允许IP数据报转发的系统,数据报转发子模块将对期望转发的数据报执行如下操作:

检测数据报头部的TTL值,为0则丢弃。

查看数据报头部的严格选路由选择选项。如果设置,则检测数据报的目标IP地址是否是本机的某个IP地址。如果不是,则发送一个ICMP源站选路失败报文给发送端。

如果有必要,则给源端发送一个ICMP重定向报文,以告诉他更合理的吓一跳。

将TTL值减1

处理IP头部选项

如有必要,执行分片

2.6 重定向 图2-3显示了ICMP重定向报文也能用于更新路由表,简要讨论ICMP重定向

a) ICMP重定向报文

ICMP重定向报文的类型值是5,代码字段有4个可选值,用来区分不同的重定向类型。本届仅讨论主机重定向,代码值为1

数据部分为接收方提供如下两个信息:

引起重定向的IP数据报的源端IP地址

应该使用的路由器IP地址

接收主机以此来选择应该使用的路由器,并且更新路由表

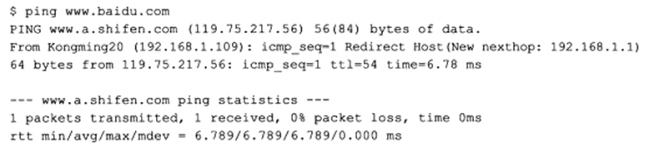

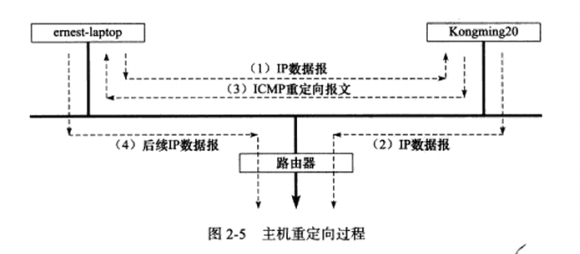

b) 主机重定向示例

2.4.3中将机器ernest-laptop的网关设置成了机器Kongming20,2.5节又使能了Kongming20的数据报转发功能,因此机器ernest-laptop将通过Kongming20来访问因特网,如在ernest-laptop上执行ping命令:

Kongming20给ernest-laptop发送了一个ICMP重定向报文,告诉它通过192.168.1.1来访问目标机器,因为这对ernest-laptop来说是更合理的路由方式。主机ernest-laptop收到这样的ICMP重定向报文后,更新路由表缓冲,并使用新的路由方式来发送后续数据报

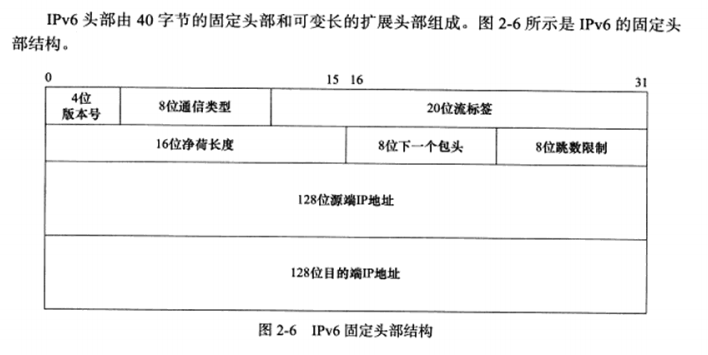

2.7 IPV6头部结构 简要讨论IPV6头部结构

a) IPV6固定头部结构

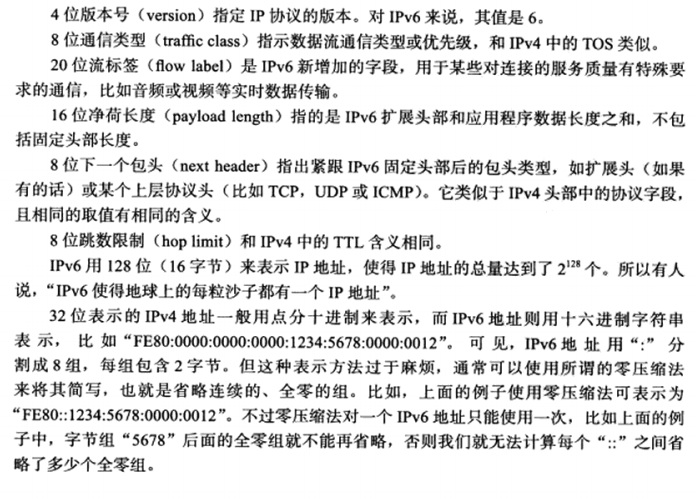

b)IPV6扩展头部

可变长的扩展头部使得IPV6可以支持更多选项,并且很便于将来的扩展需求。

第3章 TCP协议详解 本章主要从四个方面来讨论TCP协议:

TCP头部信息

TCP状态转移过程

TCP数据流

TCP数据流的控制

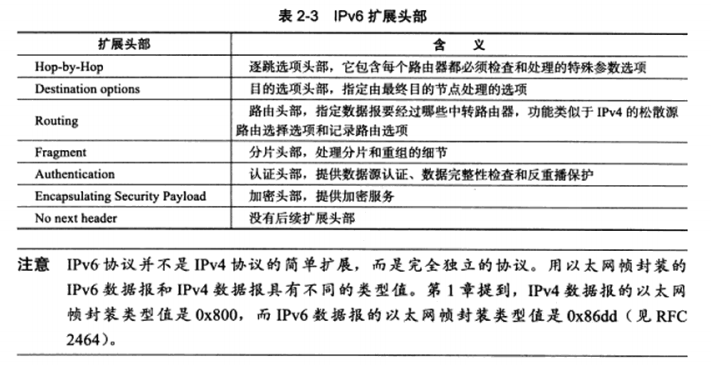

3.1 TCP服务的特点 TCP协议相对于UDP协议的特点是:面向连接,字节流和可靠传输。

TCP协议的连接是一对一的,所以基于广播和多播的应用程序,不能使用TCP服务。而无连接协议UDP非常适合广播和多播。

字节流指应用程序执行读操作次数和TCP模块接收到的TCP报文段之间没有固定的数量关系,由接收端/发送端,先接收/写到TCP发送/接收缓冲区,再由应用程序读写;与之不同的UDP则是数据报服务,发送端应用程序每执行一次写操作,UDP模块就将其封装成一个UDP数据报并发送只。

可靠,TCP协议采用发送应答机制,每个TCP报文段必须得到接收方的应答,才认为这个TCP报文传输成功。且TCP协议采用超时重传机制。以及对收到的可能乱序,重复的IP数据报,重排,整理,再交付应用层。

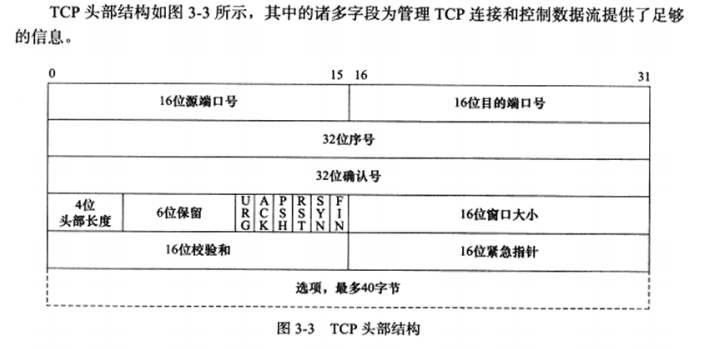

3.2 TCP头部结构 TCP头部信息出现在每个TCP报文段中。本节详细介绍

a) TCP固定头部结构

16位端口号:告知该报文段来自哪里以及传给哪个上层协议或应用程序。

32位序号:一次TCP通信过程中某一个传输方向上的字节流的每个字节的编号。

32位确认号:用作对另一方发送来的TCP报文段的响应。其值是收到的TCP报文段的序号值+1。

4位头部长度:标识该TCP头部有多少个32bit字(4字节)。4位最大表示15,所以TCP头部最长60字节。

6位标志位包含如下几项:

URG标志:表示紧急指针是否有效

ACK标志:表示确认号是否有效,携带ACK标志的TCP报文段为确认报文段。

PSH标志:提示接收端应用程序立即从TCP接收缓冲区中读走数据,为接收后续数据腾出空间。

RST标志:表示要求对方重新建立连接,携带RST为复位报文段

SYN标志:表示请求建立一个连接,携带SYN为同步报文段。

FIN标志:表示通知对方本端要关闭连接了,携带FIN为结束报文段。

16位窗口大小:TCP流量控制的一个手段。

16位校验和:接收端执行CRC算法以检验TCP报文段在传输过程中是否损坏。

16位紧急指针:是一个正的偏移量。它和序号字段的值相加表示最后一个紧急数据的下一字节的序号。

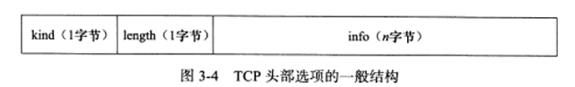

b) TCP头部选项

TCP头部的最后一个选项是可变长的可选信息。这部分最多40字节,因为TCP最长60,前面固定已占了20字节。典型的TCP头部选项结构如下:

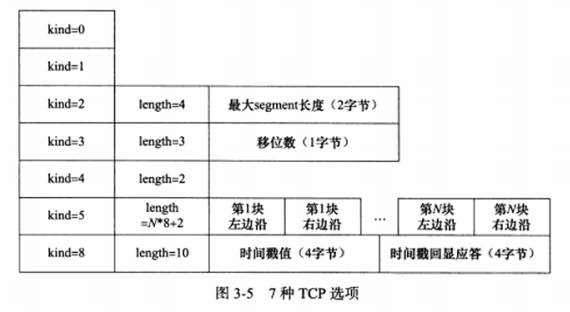

kind说明选项的类型,有的TCP选项没有后面的两个值,length指定该选项的长度,包括kind和length占据的2字节,info是选项的具体信息。常见的有7种,如下:

kind0:选项表结束选项。

kind1:空操作(nop)选项,没有特殊含义,一般用于将TCP选项的总长度填充为4字节的整数倍。

kind2:最大报文段长度选项。通信双方使用该选项来协商最大报文段长度(MSS)。通常设置为(MTU-40)字节,减掉的包括20字节IP头部和20字节TCP头部,避免IP分片。

kind3:窗口扩大因子选项。TCP头部种,接收通过窗口大小是用6位表示的(即65535),但TCP模块允许的大小远不止这个数,通过该选项可以扩大该值,如假设TCP头部中的接收通告窗口大小是N,扩大因子是M,即将N左移M位。

kind4:选择性确认选项。若通信时某个TCP报文段丢失,TCP模块会重传最后被确认的TCP报文段后续的所有报文段,这样会导致原先已经正确传输的TCP报文段被重复发送,从而降低TCP性能。该选项使TCP模块只重新发送丢失的TCP报文段。

kind5:是选择性确认(Selective Acknowledgment, SACK)实际工作的选项。

kind8:时间戳选项。该选项提供了较为准确的计算通信双方之间的回路时间(RTT)的方法。

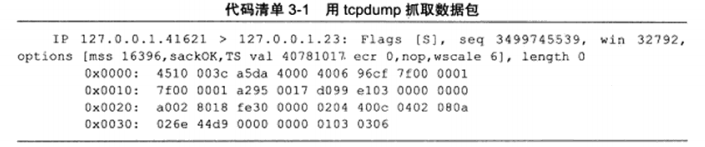

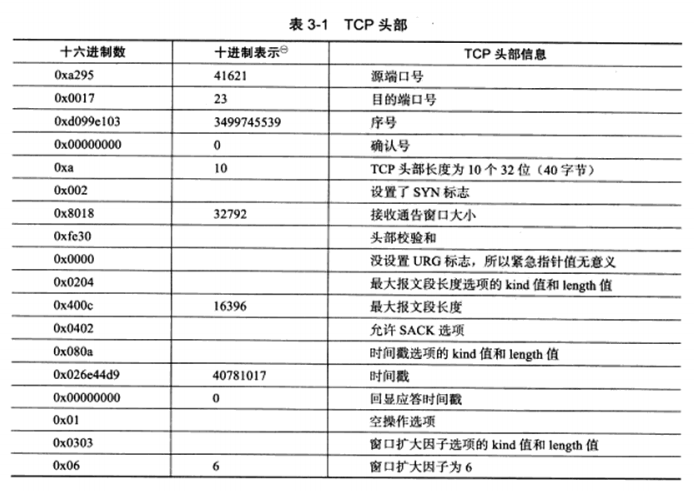

c) 使用tcpdump观察TCP头部信息

抓取的TCP报文段如下:

Flags[S]:表示包含SYN标志,因此他是一个同步报文段。

seq:序号值,因为这是该方向上第一个TCP报文段,所以这个序号值也就是本次通信该方向上的ISN(Initial Sequence Number, 初始序号值)。

win:接收通告窗口的大小。

options:tcp选项,mss为最大报文长度。通过ifconfig查看mtu为16436,所以mss为MUT-40,16396。sackOK表示同意使用SACK选项,TSval是发送端的时间戳,ecr是时间戳回显应答。nop是一个空操作,wscale指出发送端的扩大银子为6.

字节码即,TCP头部中对应的消息:

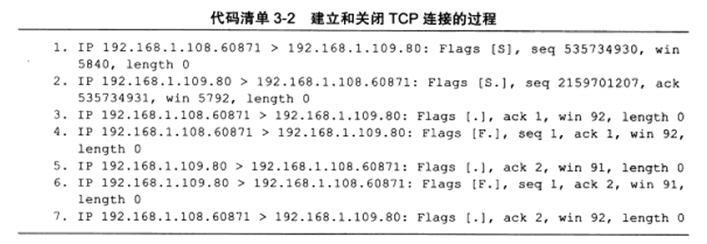

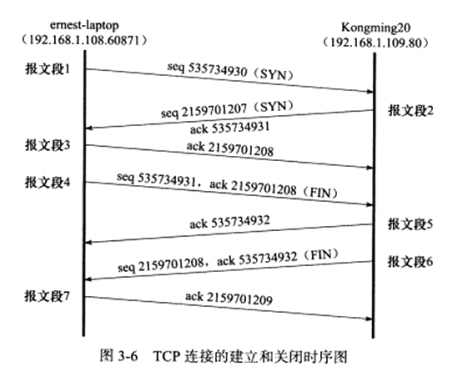

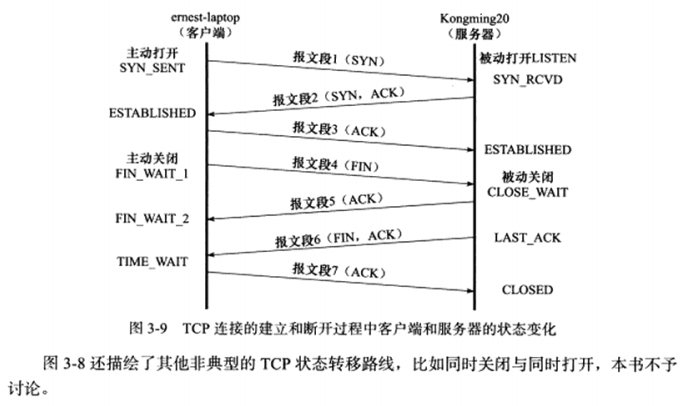

3.3 TCP连接的建立和关闭 a) 使用tcpdump观察TCP连接的建立和关闭

可以看出是三次握手建立连接,以及四次握手关闭连接

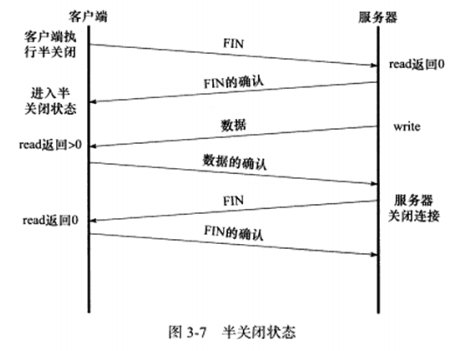

b) 半关闭状态

TCP连接是全双工的,所以它允许两个方向的数据传输被独立关闭。也就是允许一端发送结束报文,告诉对端本端已完成数据的发送,但允许继续接收来自对端的数据,直到对方也发送结束报文。

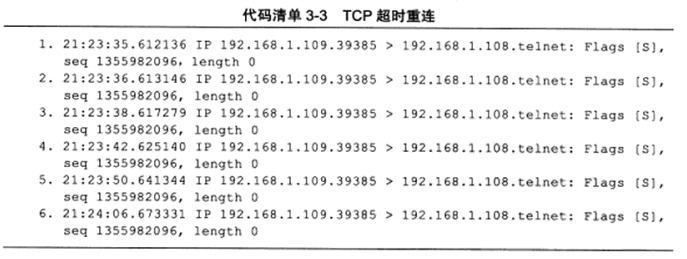

c) 连接超时

这里采用iptable命令过于数据包,丢弃它所接收到的连接请求。随后用tcpdump抓取。

可以看出在5次重连均失败的情况下,TCP模块放弃连接并通知应用程序。

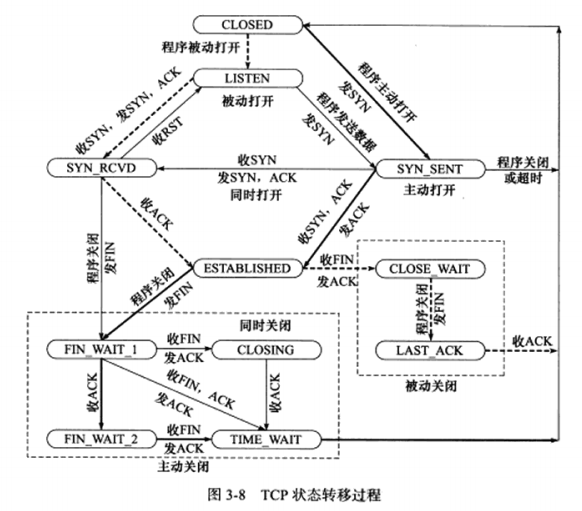

3.4 TCP状态转移 下图是完整的状态转移图,可以通过netstat命令查看TCP连接处于何种状态。

粗实线表示典型的客户端连接的状态转移,虚线可以看作服务端收到客户端的连接请求后的状态转移,CLOSED为一个假象状态,实际并不存在。

a) TCP状态转移总图

先讨论服务器典型的状态转移。

服务端listen调用进入LISTEN状态,接收到SYN,将连接放入内核等待队列,并向对端发送带SYN标志的ack确认报文段,此时处于SYN_RCVD状态。接收到对端回发的确认报文段后,转移到ESTABLISHED状态。

收到结束报文段,并返回确认报文段后,进入CLOSE_WATI状态,随后等待服务器应用程序关闭连接,发送一个结束报文段后进入LASK_ACK状态,在此等待最后一个确认,一旦确认即彻底关闭。

客户端同意,但注意一个TIME_WATI状态,后续讨论。

b) TIME_WATI状态

客户端在收到服务端的FIN后,没有立即进入CLOSED状态,而要等待一段长为2MSL(报文段最大生存时间)的时间,大概是2分钟,该状态存在的两点原因:

可靠地终止TCP连接

保证让迟来的TCP报文段有足够的时间被识别并丢弃

通过setsockopt选项SO_REUSEADDR设置端口复用,可以避免TIME_WAIT状态连接占用的端口。

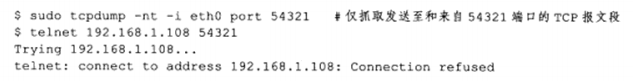

3.5 复位报文段 本节讨论产生复位报文段的三种情况

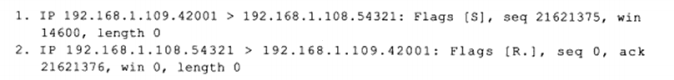

a) 访问不存在的端口

如以下命令访问一个不存在的54321端口:

抓取的TCP报文段如下:

以及对于仍处于TIME_WATI的端口发起连接,客户端程序也将收到复位报文段。

b) 异常终止连接

前面讨论的连接终止方式都是正常的种植方式:数据交换完成后,通过结束报文段。TCP提供了异常终止的一个连接方式,即给对方发送一个复位报文段。一旦发送了复位报文段,发送端所有排队等待发送的数据都被丢弃。通过使用socket选项的SO_LINGER来发送复位报文段,以异常终止一个连接。

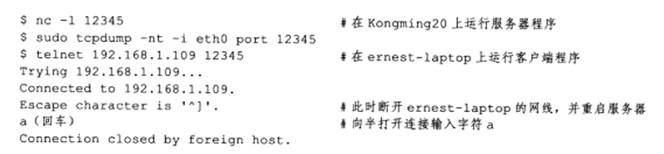

c) 处理半打开连接

如下情况,服务器关闭或异常终止了连接,而对方没有收到结束报文段,此时客户端还维持着原来的连接。如果此时客户端向半打开状态的连接写入数据,对方将回应一个结束报文段。

如执行如下命令:

tcpdump抓取的TCP报文段如下:

前3个报文段为TCP3次握手的建立,第4个报文段为客户端发送给服务器携带应用程序数据的报文段,length3,为”a”, 回车符\r , 换行符\n。

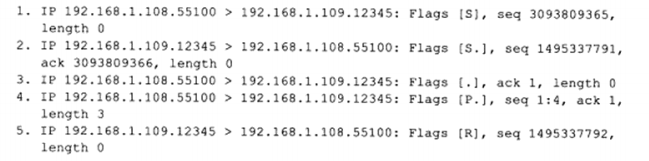

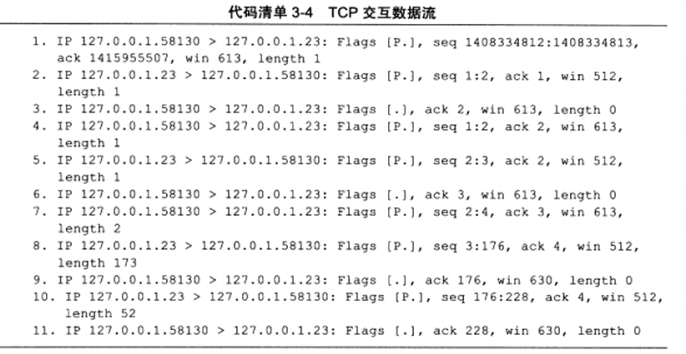

3.6 TCP交互数据流 TCP报文段锁携带的应用程序数据按照长度分为两种:交互数据和成块数据。交互数据仅包含很少的字节。对实时性要求高的应用程序一般采用该种,如telnet,ssh。成块数据长度通常为TCP报文段允许的最大数据长度,对传输效率高的应用程序采用这种如ftp。

执行如下命令:

tcpdump抓取的TCP报文段如下:

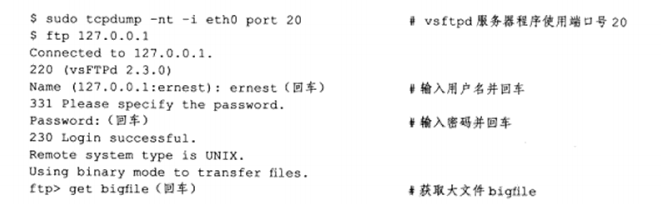

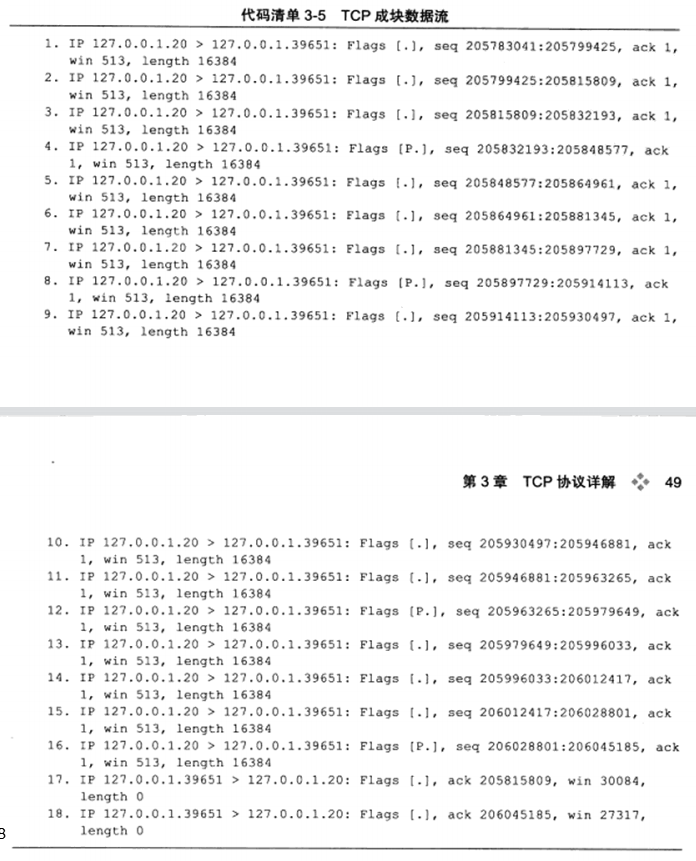

3.7 TCP成块数据流 下面考虑FTP协议传输一个大文件。命令如下:

tcpdump输出如下:

前面16个报文段都为,服务端向客户端发送数据,17,18则是客户端对于TCP报文段2和16的确认。由此可见,当传输大量大块数据的时候,发送方会连续发送多个TCP报文段。

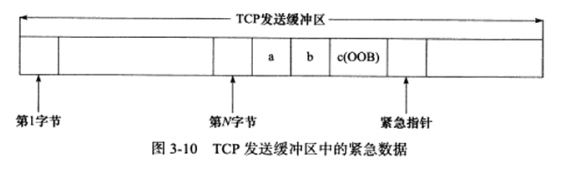

3.8 带外数据 有些传输层协议具有带外数据的概念,用于迅速通告对方本端发生的重要事件。因此,带外数据比普通数据有更高的优先级,它应该总是立即被发送,而不论发送缓冲区种是否有排队等候发送的普通数据。

UDP没有实现带外数据,TCP也米有真正的带外数据。不过TCP利用其头部种的紧急指针标志和紧急指针字段,给应用程序提供了一种紧急方式。

具体过程如下,假设一个进程已经往某个TCP连接的发送缓冲区种写入了N字节的普通数据。在数据被发送前,该进程又向这个连接写入了3字节的带外数据”abc”。此时,待发送的TCP报文段将被设置URG标志,并且紧急指针被设置为指向最后一个带外数据的下一字节。

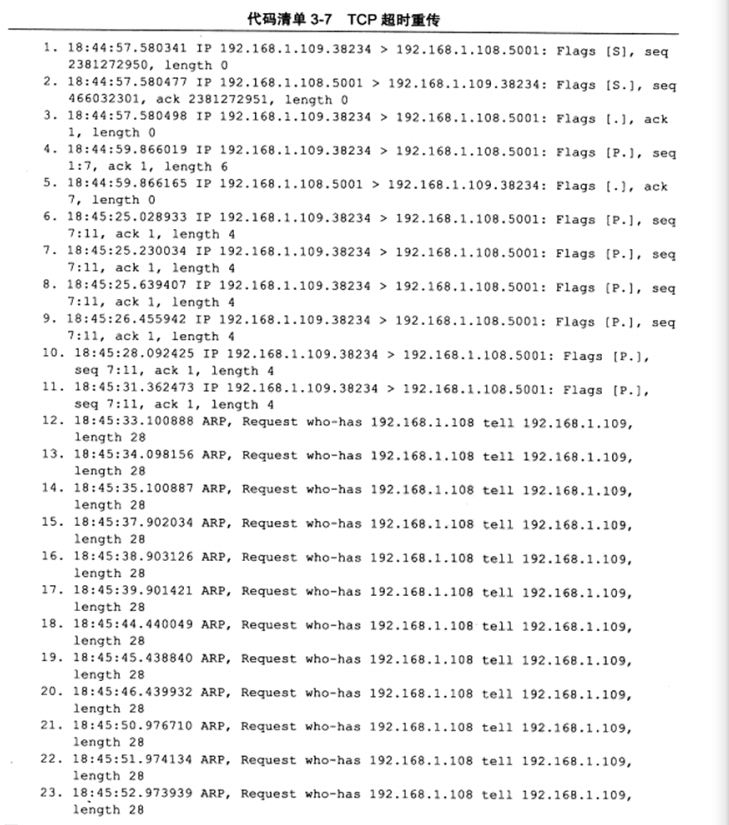

3.9 TCP超时重传 TCP服务必须能够重传超时时间内未收到确认的TCP报文段。为此,TCP模块为每个TCP报文段都维持一个重传定时器,该定时器在TCP报文段第一次被发送时启动。如果超时时间内未收到接收方的应答,TCP模块将重传TCP报文段并重置定时器。至于下次重传的超时时间如何选择,以及最多执行多少次的重传,就是TCP的重传策略,通过示例来研究。

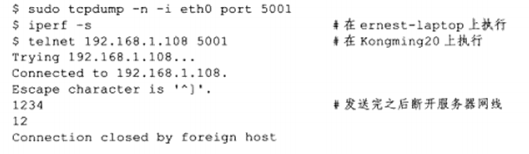

执行如下命令:

tcpdumo抓取的TCP报文段如下:

前3次为三次握手建立连接,4和5为1234数据的发送和应答,后续执行了5次重传,均失败的情况下,底层的IP和ARP开始接管,直到telnet客户端放弃连接为止。

虽然超时会导致TCP报文段重传,但TCP报文段的重传可以发生在超时之前,即快速重传。

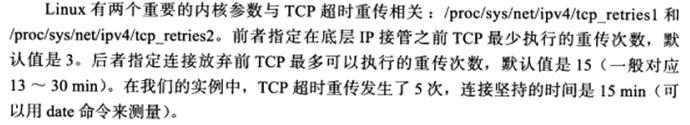

3.10 拥塞控制 a) 拥塞控制概述

TCP模块还有一个重要的任务,就是提高网络利用率,降低丢包率,并保证网络资源对每条数据流的公平性,这就是所谓的拥塞控制。

拥塞控制的四个部分:慢启动,拥塞避免,快速重传 和 快速恢复。

拥塞控制的最终受控变量是发送端向网络一次连续写入的数据量,我们称为SWND(Send Window, 发送窗口)。不过,发送端最终以TCP报文段来发送数据,所以SWND限定了发送端能连续发送的TCP报文段数量。

发送端需要合理的选择SWND的大小,如果SWND太小,会引起明显的网络延迟;反之,如果太大,则容易导致网络拥塞。接收方可以通过其接收通过窗口(RWND)来控制发送端的SWND,但这不够,所以发送端引入了一个称为拥塞窗口(Congestion Winod, CWND)的状态变量。实际的值是RWND和CWND种的较小值。

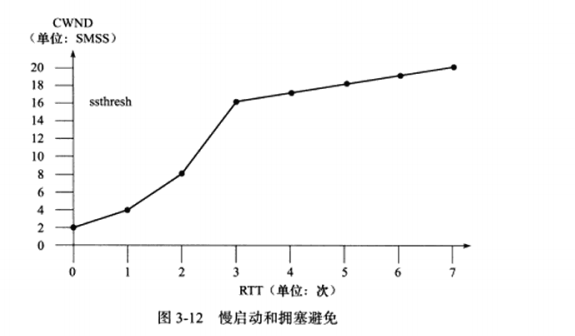

b) 慢启动和拥塞避免

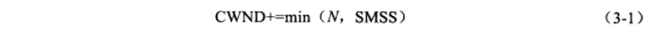

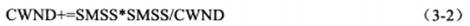

TCP连接建立好后,CWND将被设置成初始值IW(Initial Window),其大小为2~4个SMSS(Sender Maximum Segment Site,发送者最大段大小)。此时发送端最多能发送IW字节的数据。此后发送端每收到接收端的一个确认,其CWND就按照式(3-1)增加:

其中N是此次确认中包含的之前未被确认的字节数。这样一来,CWND将按照指数形式扩大,这就是所谓的慢启动。该算法的理由是,TCP模块一开始不知道网络的实际情况,通过一个试探的方式平滑的增加CWDN的大小。

但如果不施加其他手段,慢启动必然使得CWND膨胀,导致网络阻塞。因此TCP拥塞控制中定义了另一个重要的状态变量:慢启动门限(ssthresh) 。当CWND的大小超过该值时,TCP拥塞控制将进入拥塞避免阶段。

拥塞避免算法使得CWND按线性方式增加,从而减缓其扩大。两种实现方式:

每个RTT时间内按照(3-1)计算新的CWND,而不论该RTT时间内发送端接收到多少个确认。

没收到一个对新数据报的确认报文段,按(3-2)来更新CWND

如果给出一张图示,如下:

以上为发送端在未检测到拥塞时所采用的积极避免拥塞的方法。接下来介绍拥塞发生时拥塞控制行为。首先搞清除发送端如何判断拥塞已经发生,依据有两个:

传输超时,或者说TCP重传定时器溢出

接收到重复的确认报文段

拥塞控制对这两种情况有不同的处理方式,对第一种情况仍然使用慢启动和拥塞避免。对第二种情况则使用快速重传和而快速恢复,这种情况随后讨论。注意如果第二种情况发生在重传定时器溢出之后,则也被拥塞控制当成第一种情况来对待。

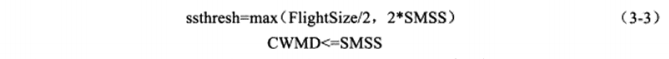

如果发送端检测到拥塞发生是由于传输超时,即第一种情况,将执行重传并做如下调整:

其中FlightSize是已经发送但未接收到确认的字节数,这样调整之后,CWND将一定小于SMSS,那么也必然小于新的慢启动门限ssthresh,故而拥塞控制再次进入慢启动阶段。

c) 快速重传和快速恢复

在很多情况下,发送端都可能收到重复的确认报文段。如TCP报文段丢失,或者接收端收到乱序TCP报文段并重排之等。拥塞控制算法首先需要判断网络是否真的发生了阻塞。具体做法是:如果连续收到3个重复的确认报文段,就认为是拥塞发生了。然后它启用快速重传和快速恢复算法来处理拥塞,过程如下:

1.收到3个重复确认报文段时,按式(3-3)计算ssthresh,然后立即重传丢失的报文段,并按照式(3-4)设置CWND

2.每次收到1个重复的确认时,设置CWND = CWND + SMSS。此时发送端可以发送新的TCP报文段,如果CWND允许的话。

3.当收到新的数据的确认时,设置CWND = ssthresh 该慢启动门限为新的,由第一步设置

快速重传和快速恢复完成后,拥塞控制将恢复到拥塞避免阶段。

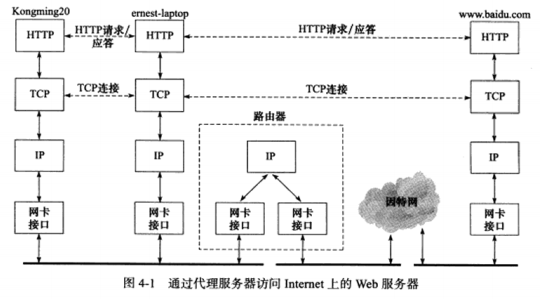

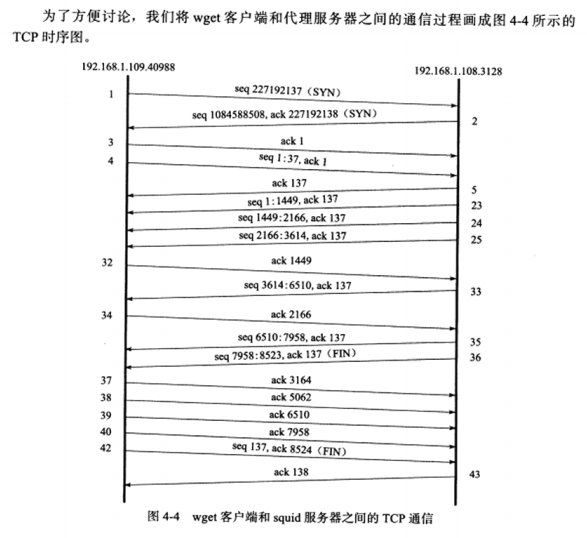

第4章 TCP/IP通信案例:访问Internet上的Web服务器 4.1 示例总图 在Kongming20上运行wget客户端,在ernest-laptop运行squid代理服务器程序。客户端通过代理服务器的中专,获取Internet上的主机www.baidu.com的首页文档index.html

为了将ernest-laptop设置为Kongming20的HTTP代理服务器,需要在Kongming20上设置环境变量http_proxy:

1 $ export http_proxy="ernest-laptop:3128"

3128为squid服务器默认使用的端口号。

4.2 部署代理服务器 简单介绍代理服务器的工作原理以及如何部署。

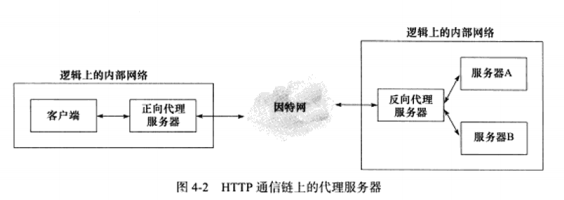

a) HTTP代理服务器的工作原理

HTTP通信链上,客户端和目标服务器之间通常存在某些中转代理服务器,它们提供对目标资源的中转访问。代理服务器按照其使用方式和作用,分为正向代理服务器,反向代理服务器和透明代理服务器。

正向代理:要求客户端自己设置代理服务器的地址。客户每次的请求都直接发送到该代理服务器,并由代理服务器来请求目标资源。

反向代理:反向代理被设置在服务器端,因此客户端无须进行任何设置。方向代理用代理服务器来接收internet上的连接请求,然后将请求转发给内部网络上的服务器,并将从内部服务器上得来的结果返回给客户端。

透明代理:只能设置在网关上。透明代理可以看作正向代理的一种特殊情况。

b) 部署squid代理服务器

在ernest-laptop上部署squid代理服务器。只需修改服务器的配置文件/etc/squid3/suiqd.conf,在其加入如下两行代码(需要root权限,应加在合适的为止,详细参考其他类似条目的设置):

1 2 acl localnet src 192.168 .1 .0 /24 http_access allow localnet

192.168.1.0/24是CIDR(Classless Inter-Domain Routing,无类域间路由)风格的IP地址表示方法。

接下来在ernest-laptop上执行如下命令,以重启squid服务器:

1 2 $ sudo service squid3 restart *Restarting Squid HTTP Proxy 3.0 squid3 [ok]

service是一个脚本程序,为/etc/init.d/目录下的众多服务器程序的启动,停止等动作提供了一个统一的管理。

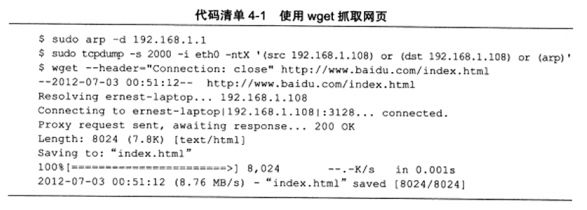

4.3 使用tcpdump抓取传输的数据包 执行wget命令前,首先删除ernest-laptop的ARP高速缓存,以便观察TCP/IP通信过程中ARP协议何时起作用,完整操作如下:

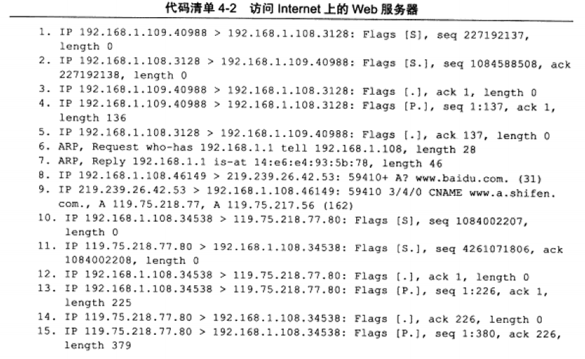

一共抓取了43个数据包,按照逻辑关系分为如下四部分:

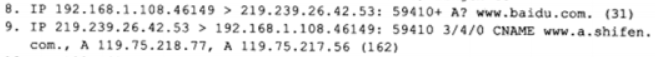

代理服务器访问DNS服务器查询域名www.baidu.com对应的IP地址,数据包8,9。

代理服务器查询路由器MAC地址的ARP请求和应答,数据包6,7。

wget客户端(192.168.1.109)和代理服务器(192.168.1.108)之间的HTTP通信,数据包15,2325,32~40,42,43。

代理服务器和Web服务器(119.75.218.77)之间的HTTP通信,数据包1022,2631,41。

4.4 访问DNS服务器 数据包8,9表示代理服务器向DNS服务器查询域名www.baidu.com对应的IP地址,得到回应。回复包括一个主机别名和两个IP地址。

完整过程如下图:

4.5 本地名称查询 通过域名来访问internet上的某台主机时,需要使用DNS服务来获取该主机的IP地址。但如果通过主机名来访问本地局域网上的机器,则可通过本地的静态文件来获得该机器的IP地址。

Linux将目标主机及其对应IP地址存储在/etc/hosts配置文件中。如Kongming20上/etc/hosts文件的内容如下:

1 2 3 127.0 .0 .1 localhost192.168 .1 .109 Kongming20192.168 .1 .108 ernest-laptop

程序在/etc/hosts文件中未找到目标机器名对应的IP地址,它将求助于DNS服务。

用户可以通过修改/etc/host.conf文件来自定义系统解析主机名的方法和顺序。

4.6 HTTP通信

本例的过程中,客户端仅给服务器发送了一个HTTP请求,即TCP报文段4,请求的长度为136字节。代理用6个TCP报文段(23,24,25,33,35,36)给客户端返回了总长度为8522字节的HTTP应答。客户端使用7个TCP报文段(32,34,37,38,39,40,42)来确定这8552字节的HTTP应答数据。

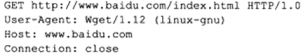

a) HTTP请求

请求的部分内容如下:

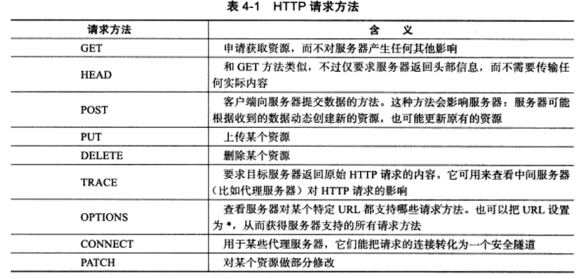

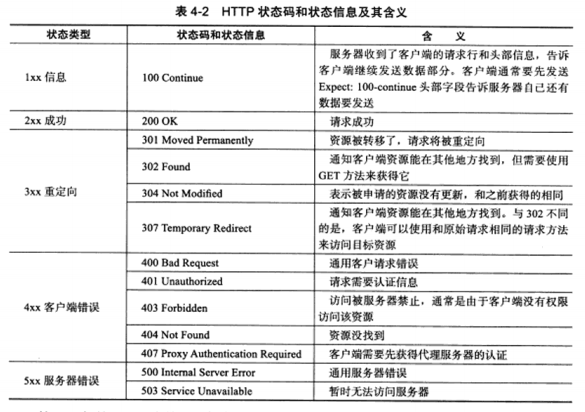

GET为请求方法,一共有如下9种:

http://www/baidu/com/index.html 是目标资源的URL,”http”是所谓的scheme,表示获取目标资源所需使用的应用层协议。www.baidu.com是目标主机,index.html是指定资源文件名称

HTTP/1.0表示客户端使用的HTTP版本号是1.0。

User-Agent表示客户端使用的程序。

Host表示目标主机名。

Conection表示如何处理连接方式。

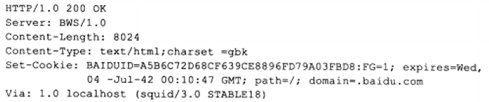

b) HTTP应答

第一行是状态行,HTTP/1.0表示服务器使用的协议版本号,通常需要和客户端一致。

往下分别是,服务器程序名,目标内容的长度,目标内容的MIME类型,以及cookie。

via表示HTTP应答在返回过程中经历的所有代理服务器的地址和名称。

第5章 Linux网络编程基础API 5.1 socket地址API a) 主机字节序和网络字节序

不同规定导致的字节沿地址增长方向不同,高位存储在低地址为大端字节序,高位存储在高地址,则为小端。

1 2 3 4 5 6 7 8 9 10 11 12 13 14 15 16 17 #include <stdio.h> void byteorder () { uninon { short value; char union_bytes[sizeof (short )]; } test; test.value = 0x0102 ; if ((test.union_bytes[0 ] == 1 ) && (test.union_bytes[1 ] == 2 )) { printf ("big endian\n" ); } else if ((test.union_bytes[0 ] == 2 ) && (test.union_bytes[1 ] == 1 )) { printf ("little endian\n" ); } else { printf ("unkonwn...\n" ); } }

Linux提供了如下4个函数来完成主机字节序和网络字节序之间的转换

1 2 3 4 5 #include <netinet/in.h> unsigned long in htonl (unsigned long int hostlong) ;unsigned short int htons (unsigned short int hostshort) ;unsigned long in ntohl (unsigned long int netlong) ;unsigned short int ntohs (unsigned short int netshort) ;

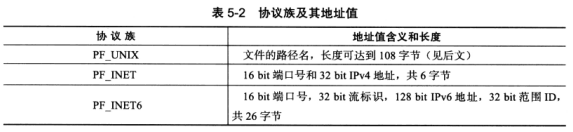

b) 通用socket地址

socket网络编程中表示socket地址的结构体如下:

1 2 3 4 5 #include <bits/socket.h> struct sockaddr { sa_family_t sa_family; char sa_data[14 ]; }

由于14字节的sa_data无法容纳众多数的协议族的地址值。下面为新的通用地址

1 2 3 4 5 6 #include <bits/socket.h> struct sockaddr_storage { sa_family_t sa_family; unsigned long int __ss_align; char __ss_padding[128 -sizeof (__s_align)]; }

且该结构是内存对齐的

c) 专用socket地址

UNIX本地域协议族使用如下专用socket地址结构体:

1 2 3 4 5 #include <sys/un.h> struct sockaddr_un { sa_family_t sin_family; char sun_path[108 ]; }

TCP/IP,分为IPV4的和IPV6的

1 2 3 4 5 6 7 8 9 10 11 12 13 14 15 16 17 18 19 struct sockaddr_in { sa_family_t sin_family; u_int16_t sin_port; struct in_addr sin_addr ; }; struct in_addr { u_int32_t s_addr; }; struct sockaddr_in6 { sa_family_t sin6_family; u_int16_t sin6_port; u_int32_t sin6_flowinfo; struct in6_addr sin6_addr ; u_int32_t sin6_scope_id; }; struct in6_addr { unsigned char sa_addr[16 ]; };

d) IP地址专函函数

下面3个函数可用于点分十进制字符串到网络字节序整数之间的转换:

1 2 3 4 5 6 7 8 9 10 11 12 13 #include <arpa/inet.h> in_addr_t inet_addr (const char * strptr) ;int inet_aton (const char * cp, struct in_addr * inp) ;char * inet_ntoa (struct in_addr in) ;char * szValue1 = inet_ntoa("1.2.3.4" );char * szValue2 = inet_ntoa("10.194.71.60" );printf ("address 1: %s\n" , szValue1);printf ("address 2: %s\n" , szValue2); address1: 10.194 .71 .60 address1: 10.194 .71 .60

下面这对更新的函数也能完成和前面3个函数同样的功能,并且同时适用于IPV4和IPV6

1 2 3 4 5 6 7 8 #include <arpa/inet.h> int inet_pton (int af, const char *src, void *dst) ;const char *inet_ntop (int af, const void *src, char *dst, socklen_t cnt) ;#include <netinet/in.h> #define INET_ADDRSTRLEN 16 #define INET6_ADDRSTRLEN 46

5.2 创建socket 1 2 3 #include <sys/socket.h> #include <sys/types.h> int socket (int domain, int type, int protocol) ;

domain参数指明使用哪个底层协议,如AF_INET,AF_INET6,AF_UNIX。

type参数指定服务类型。主要为SOCKET_STREAM(流服务)适用于TCP协议,SOCK_DGRAM(数据报服务)适用于UDP协议。

protocol在前两个参数的前提下,指定一个具体的协议。因为前两个参数基本已经完全决定了它的值。在几乎所有情况下,把它设置为0,表示默认协议。

5.3 命名socket 即将sockaddr绑到socket上去:

1 2 3 #include <sys/types.h> #include <sys/socket.h> int bind (int sockfd, const struct sockaddr *my_addr, socklen_t addrlen) ;

常见的两种errno

EACCES:被保定的地址是受保护的地址,仅超级用户能访问。

EADDRINUSE:被绑定地址正在使用中。比如绑到一个处于TIME_WAIT状态的socket地址。

5.4 监听socket 创建监听队列存放待处理的客户连接:

1 2 #include <sys/socket.h> int listen (int sockfd, int backlog) ;

backlog参数在内核版本2.2之后,表示完全处于连接状态的socket上线,处于半连接状态的socket上线由 /proc/sys/ipv4/tcp_mas_syn_bakclog内核参数定义。

5.5 接受连接 下面的系统调用从listen监听队列中接受一个连接:

1 2 3 #include <sys/types.h> #include <sys/socket.h> int accept (int sockfd, struct sockaddr *addr, socklen_t addrlen) ;

accept成功时返回一个新的连接socket,该socket唯一地标识了被接收的这个连接。

5.6 发起连接 客户端通过如下系统调用来主动与服务器建立连接:

1 2 3 #include <sys/types.h> #include <sys/socket.h> int connect (int sockfd, const struct sockaddr *serv_addr, socklen_t addrlen) ;

失败常见的两种errno:

ECONNREFUED:目标端口不存在,连接被拒绝。

ETIMEDOUT:连接超时。

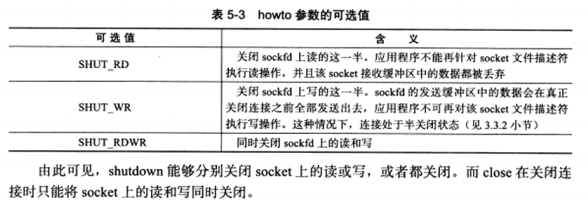

5.7 关闭连接 关闭连接,也就是关闭对应的socket,通过如下系统调用:

1 2 #include <unistd.h> int close (int fd) ;

close实际上的操作,是将文件描述符fd的引用计数减1,只有引用计数为0时,才真正关闭连接。所以在多进程程序中,一次fork调用会导致父进程中打开的socket引用计数加1,只有父子进程都执行了close,才能将连接关闭。

如果想立即终止连接,可以使用shutdown系统调用:

1 2 #include <sys/socket.h> int shutdown (int sockfd, int howto) ;

howto参数决定shutdown的行为:

5.8 数据读写 a) TCP数据读写

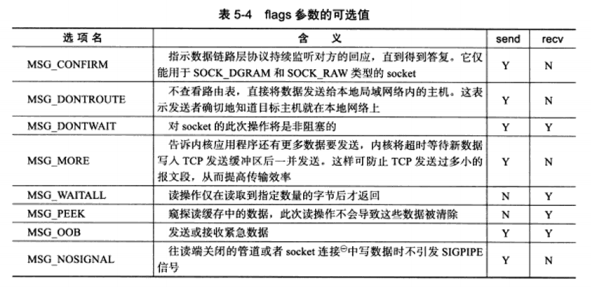

socket编程接口提供的几个用于TCP流数读写的系统调用:

1 2 3 4 #include <sys/types.h> #include <sys/socket.h> ssize_t recv (int sockfd, void *buf, size_t len, int flags) ;ssize_t send (int sockfd, const void *buf, size_t len, int flags) ;

flags参数为数据收发提供了额外的控制,具体可选值如下表:

MSG_OBB选项给应用程序提供了发送和接收带外数据方法,如下:

1 2 3 4 5 6 7 8 9 10 11 12 13 14 15 16 17 18 19 20 21 22 23 24 25 26 27 28 29 30 31 32 33 34 35 36 37 38 39 40 41 42 43 44 45 46 47 48 49 50 51 52 53 54 55 56 57 58 59 60 61 62 63 64 65 66 67 68 69 70 71 72 73 74 75 76 77 78 79 80 81 82 83 84 85 86 87 88 89 90 91 92 93 94 95 96 97 98 99 100 101 102 103 104 105 106 107 108 109 110 111 112 113 #include <sys/socket.h> #include <netinet/in.h> #include <arpa/inet.h> #include <assert.h> #include <stdio.h> #include <unistd.h> #include <string.h> #include <stdlib.h> int main (int argc, char *argv[]) { if (argc <=2 ) { printf ("usage: %s ip_address port_number\n" , basename( argv[0 ]) ); return 1 ; } const char *ip = argv[1 ]; int port = atoi( argv[2 ] ); struct sockaddr_in serv_address ; bzero( &serv_address, sizeof (serv_address) ); serv_address.sin_family = AF_INET; inet_pton(AF_INET, ip, &serv_address.sin_addr ); serv_address.sin_port = htons(port); int sockfd = socket(AF_INET ,SOCK_STREAM, 0 ); assert(sockfd >= 0 ); if (connect(sockfd, (struct sockaddr*)&serv_address, sizeof (serv_address)) < 0 ) { printf ("connection failed\n" ); } else { const char * obb_data = "abc" ; const char * normal_data = "123" ; send(sockfd, normal_data, strlen (normal_data), 0 ); send(sockfd, obb_data, strlen (obb_data), MSG_OBB); send(sockfd, normal_data, strlen (normal_data), 0 ); } close(sockfd); return 0 ; } #include <sys/socket.h> #include <netinet/in.h> #include <arpa/inet.h> #include <assert.h> #include <stdio.h> #include <unistd.h> #include <string.h> #include <stdlib.h> #include <errno.h> #define BUF_SIZE 1024 int main (int argc, char *argv[]) { if ( argc <= 2 ) { printf (...); return 1 ; } const char *ip = argv[1 ]; int port = atoi( argv[2 ] ); struct sockaddr_int address ; bzero( &address, sizeog(address) ); address.sin_family = AF_INET; inet_pton( AF_INET, ip, &address.sin_addr ); address.sin_port = htons( port ); int sock = socket(AF_INET, SOCK_STREAM, 0 ); assert( sock >= 0 ); int ret = bind(sock, (struct sockaddr*)&address, sizeof (address) ); assert( ret != 1 ); ret = listen( sock, 5 ); assert( ret != 1 ); struct sockaddr_in client ; socklen_t clinet_addrlength = sizeof (client); int connfd = accept( sock, (struct sockaddr*)&client, &client_addrlength ); if ( connfd < 0 ) { printf ("errno is: %d\n" , errno); } else { char buffer[ BUF_SIZE ]; memset ( buffer, '\0' , BUF_SZIE ); ret = recv( connfd, buffer, BUF_SIZE-1 , 0 ); printf ("got %d bytes of normal data '%s'\n" , ret, buffer ); memset ( buffer, '\0' , BUF_SZIE ); ret = recv( connfd, buffer, BUF_SIZE-1 , MSG_OBB ); printf ("got %d bytes of obb data '%s'\n" , ret, buffer ); memset ( buffer, '\0' , BUF_SZIE ); ret = recv( connfd, buffer, BUF_SIZE-1 , 0 ); printf ("got %d bytes of normal data '%s'\n" , ret, buffer ); close( connfd ); } close( sock ); return 0 ; } got 5 bytes of normal data '123ab' got 1 bytes of obb data 'c' got 3 bytes of normal data '123'

b) UDP数据读写

socket编程中用于UDP数据报读写的系统调用:

1 2 3 4 5 6 #include <sys/types.h> #include <sys/socket.h> ssize_t recvfrom (int sockfd, void *buf, size_t len, int flags, struct sockaddr* src_addr , socklen_t *addrlen) ;ssize_t sendto (int sockfd, const void *buf, size_t len, int flags , const struct sockaddr *dest_addr, socklent_t addrlen) ;

UDP没有通信的概念,所以每次读取和发送数据都需要指定目标的socket地址。

该系统调用也可以用于面向连接的socket,只需要把最后两个参数设置为NULL,忽略地址。

c) 通用数据读写函数

1 2 3 4 5 6 7 8 9 10 11 12 13 14 15 16 17 18 #include <sys/socket.h> ssize_t recvmsg ( int sockfd, struct msghdr *msg, int flags ) ;ssize_t sendmsg ( int sockfd, struct msghdr *msg, int flags ) ;struct msghdr { void *msg_name; socklen_t msg_namelen; struct iovec * msg_iov ; int msg_iovlen; void *msg_contorl; socklen_t msg_contorllen; int msg_flags; }; struct iovec { void *iov_base; size_t iov_len; };

iovec用于分散读和集中写。

msg_control,辅助数据,13章介绍如何使用它们来实现进程间传递文件描述符。

5.9 带外标记 前面演示了TCP带外数据的接收方法,但实际应用中,无法预期带外数据何时到来。所以有了如下系统调用:

1 2 #include <sys/socket.h> int sockatmark ( int sockfd ) ;

sockatmark判断sockfd是否处于带外标记,即下一个被读取的数据是否是带外数据。如果是返回1,此时就可以利用带MSG_OBB标志的recv调用来接收带外数据。

5.10 地址信息函数 用以知道本端的socket地址,以及远端的socket地址:

1 2 3 #include <sys/socket.h> int getsockname ( int sockfd, struct sockaddr* address, socklen_t *address_len ) ;int getpeername ( int sockfd, struct sockaddr* address, socklen_t *address_len ) ;

getsockname获取本端的,getpeername获取对端的。

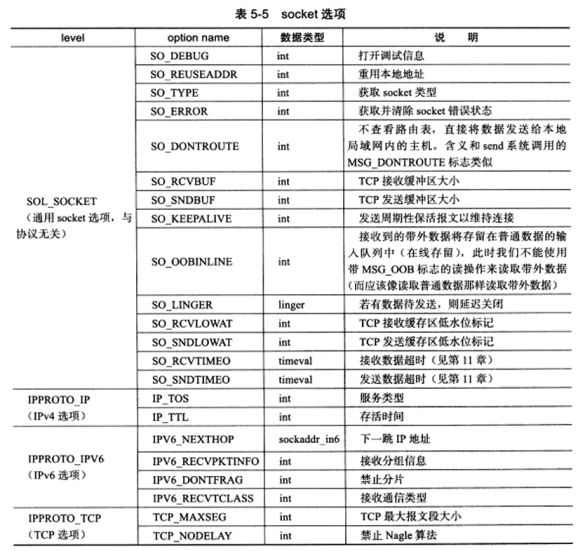

5.11 socket选项 下面两个系统调用用来读取和设置socket文件描述符属性:

1 2 3 4 5 #include <sys/socket.h> int getsockopt ( int sockfd, int level, int option_name, void *option_value, socklen_t *restrict option_len ) ;int setsockopt ( int sockfd, int level, int option_name, const void *option_value, socklen_t option_len ) ;

a) SO_REUSEADDR选项

通过设置该选项,强制使用处于被TIME_WAIT状态的连接占用的socket地址

1 2 3 4 5 6 7 8 9 10 11 12 int sock = socket( AF_INET ,SOCK_STREAM, 0 );assert( sock >= 0 ); int reuse = 1 ;setsockopt( sock, SOL_SOCKET, SO_REUSEADDR, &reuse, sizeog( reuse ) ); struct sockaddr_in address ;bzero( &address, sizeof ( address ) ); address.sin_family = AF_INET; inet_pton( AF_INET, ip, &address.sin_addr ); address.sin_port = htons( port ); int ret = bind( sock, (struct sockaddr*)&address, sizeof ( address ) );

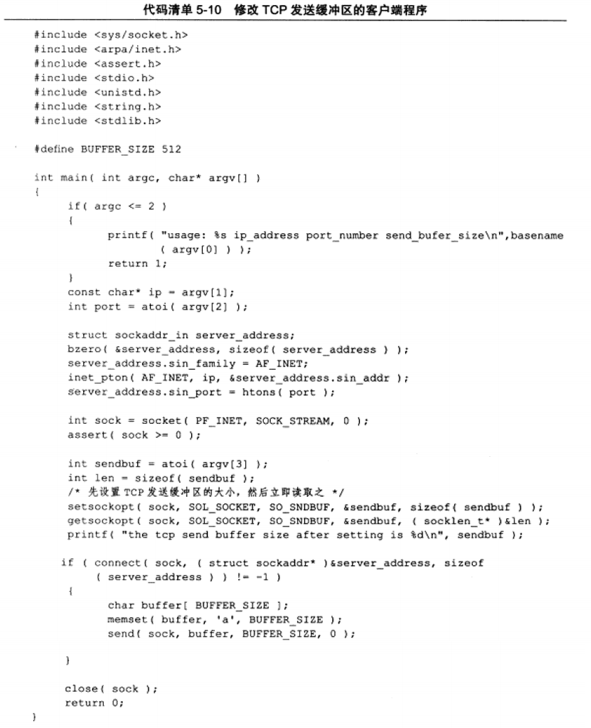

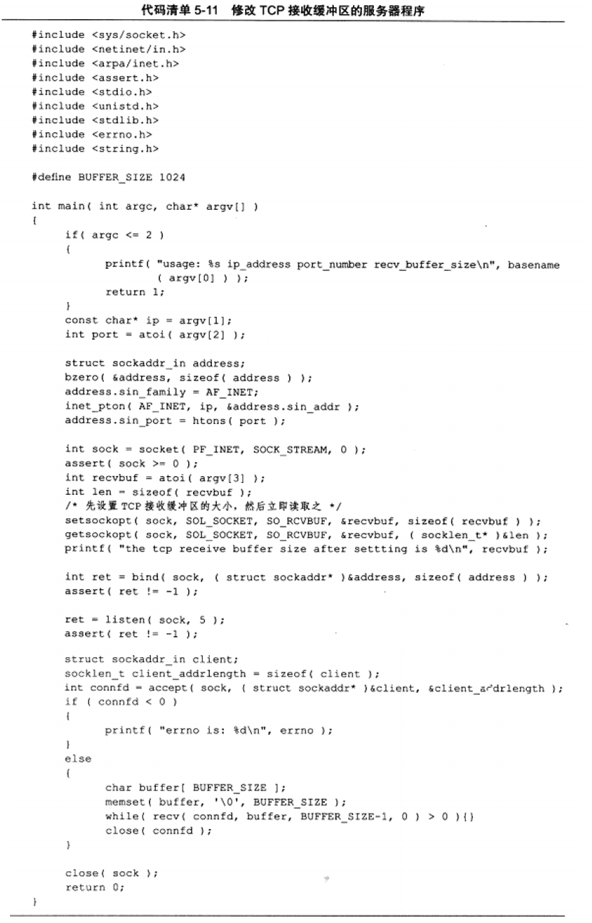

b) SO_RCVBUF和SO_SNDBUF选项

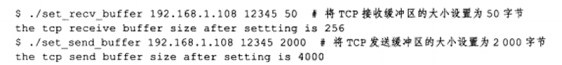

设置接收缓冲区和发送缓冲区的大小时,系统都会将其值加倍,并且不得小于某个最小值。TCP接收缓冲区的最小值是256,发送缓冲最小值是2048。目的是,确保一个TCP连接拥有足够的空间缓冲区来处理拥塞。通过之间修改内核参数可以强制其没有最小值限制。

执行如下:

可以看出50字节的设置没有成功,系统将其设置为了最小值256,2000成功了,且系统将其实际上加倍

c) SO_RCVLOWAT和SO_SNDLOWAT选项

SO_RCVLOWAT和SO_SNDLOWAT选项分别标识TCP接收缓冲区和发送缓冲区的低水位标记。一般用于I/O复用系统调用用来判断socket是否可读或可写。当TCP接收缓冲区中可读数据的总数大于其低水位标记时,通常读数据;当TCP发送缓冲区的空闲空间大于其低水位标记时,通知写数据。

一般默认值均为1字节。

d) SO_LINGER选项

SO_LINGER选项用来控制close系统调用在关闭TCP连接时的行为。默认情况下,close关闭socket,close立即返回,TCP模块负责把socket对应TCP发送缓冲区中残留的数据发送给对方。

设置该选项,需用传递一个linger类型的结构体:

1 2 3 4 5 #include <sys/socket.h> struct linger { int l_onoff; int l_linger; };

根据参数的不同有如下三种行为:

1) l_onoff等于0,此时该选项不起作用,与close默认类似

1) l_onoff不为0,l_linger等于0,此时close立即返回,丢弃残留的数据,同时发送一个复位报文段。因此,这种情况给服务器提供了异常终止一个连接的方法。

1) l_onoff不为0,l_linger大于0。此时close的行为取决于两个条件:一是被关闭的socket对应的发送缓冲区是否有残留数据,二是socket是阻塞的还是非阻塞的。对于阻塞的,close等待一段长为l_linger的时间,直到残留数据被发送完并且得到对方的确认。如果没有发送完并得到确认,返回-1并设置errno为EWOULDBLOCK。如果是非阻塞,close立即返回。

5.12 网络信息API 简单来说避免直接使用IP地址,通过之后的一些函数实现,主机名代替IP地址,服务名代替端口号

1 2 telnet 127.0.0.1 80 telnet localhost www

a) gethostbyname和gethostbyaddr

分别根据主机名获取主机的完整信息和根据IP地址获取主机的完整信息。

1 2 3 4 5 6 7 8 9 10 11 #include <netdb.h> struct hostent * gethostbyname ( const char * name ) ;struct hostent * gethostbyaddr ( const void * addr, size_t len, int type) ;struct hostent { char * h_name; char ** h_aliases; int h_addrtype; int h_length; char ** h_addr_list; };

b) getservbyname和getservbyport

根据名称获取某个服务的完整信息,和根据端口号获取。

1 2 3 #include <netdb.h> struct servent * getservbyname ( const char * name, const char * proto ) ;struct servent * getservbyport ( int port, const char * proto ) ;

proto参数指定服务类型,”tcp”标识获取流服务,”udp”标识获取udp服务,NULL标识所有服务类型。

1 2 3 4 5 6 7 #include <netdb.h> struct servent { char *s_name; char ** s_aliases; int s_port; char * s_proto; };

例子:通过主机名和服务名访问目标服务器上的daytime服务。

1 2 3 4 5 6 7 8 9 10 11 12 13 14 15 16 17 18 19 20 21 22 23 24 25 26 27 28 29 30 31 32 33 34 35 36 37 38 #include <netinet/in.h> #include <netdb.h> #include <sys/socket.h> #include <stdio.h> #include <unistd.h> #include <assert.h> int main (int argc, char *argv[]) { assert( argc == 2 ); char *host = argv[1 ]; struct hostent *hostinfo = assert( hostinfo ); struct servent *servinfo ="daytime" , "tcp" ); assert( servinfo ); printf ( "daytime port is %d\n" , ntohs( servinfo->s_port ) ); struct sockaddr_in address ; address.sin_family = AF_INET; address.sin_port = servinfo->s_port; address.sin_addr = *( struct in_addr* )*hostinfo->h_addr_list; int sockfd = socket( AF_INET, SOCK_STREAM, 0 ); int result = connect( sockfd, (struct sockaddr*)&address, sizeof ( address ) ); assert( result != -1 ); char buffer[128 ]; result = read( sockfd, buffer, sizeof ( buffer ) ); assert( result > 0 ); buffer[result] = '\0' ; printf ( "the day time is: %s" , buffer ); close( sockfd ); return }

c) getaddrinfo

getaddrinfo既能通过主机名获取IP地址,也能通过服务名获取端口号

1 2 3 #include <netdb.h> int getaddrinfo (const char *hostname, const char *service, const struct addrinfo *hints, struct addrinfo ** result) ;

hitns参数用以给getaddrinfo一个目标期望,resulst参数指向一个链表,用于存储反馈结果。

1 2 3 4 5 6 7 8 9 10 struct addrinfo { int ai_flags; int ai_family; int ai_socktype; int ai_protocol; socklen_t ai_addrlen; char *ai_canonname; struct sockaddr *ai_addr ; struct addrinfo *ai_next ; };

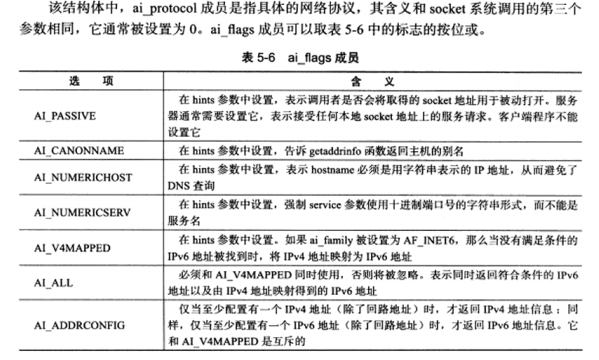

当我们使用hints参数时,可以设置其ai_flags,ai_family,ai_socktype和ai_protocol四个字段,用法如下:

1 2 3 4 5 6 struct addrinfo hints ;struct addrinfo *res ;bzero( &hitns, sizeof (hints) ); hints.ai_socktype = SOCK_STREAM; getaadrinfo( "ernest-laptop" , "daytime" , &hints, &res);

表示只获取主机ernest-laptop上daytime的流服务,也就是TCP服务。

在getaddrinfo调用结束后,使用如下函数释放内存:

1 2 #include <netdb.h> void freeaadrinfo ( struct addrinfo *res ) ;

d) getnameinfo

getnameinfo函数能通过socket地址同时获得以字符串表示的主机名和服务名。

1 2 3 #include <netdb.h> int getnameinfo ( const struct sockaddr *sockaddr, socklen_t addrlen, char *host, socklen_t hostlen, char *serv, socklen_t servlen, int flags) ;

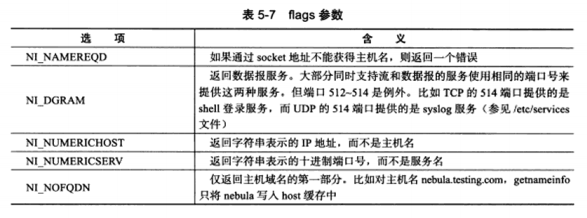

flags参数控制getnameinfo的行为,如下:

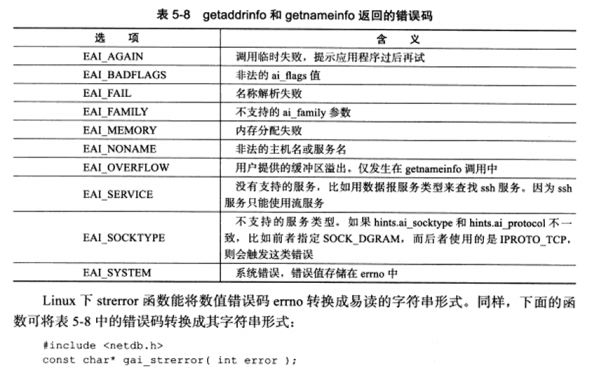

失败时返回的错误码表如下:

第6章 高级I/O函数 诸如pipe,dup/dup2等这类函数的介绍

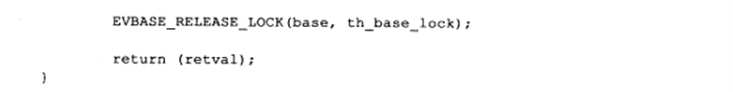

6.1 pipe函数 pipe函数可用于创建一个管道,以实现进程间通信。本章只讨论基本使用方式:

1 2 #include <unistd.h> int pipe (int fd[2 ]) ;

fd[0]和fd[1]分别构成管道的两端,fd[1]为写端,fd[0]为读端。并且是单向的,如果要实现双向的数据传输,需要两根管道。如果管道的写端fd[1]的引用计数减少至0,针对该管道的读端fd[0]的read操作将返回0,即读到文件结束标记(EOF)。反之如果读端fd[0]的引用计数减少至0,针对该管道的写端fd[1]的write操作将失败,并引发SIGPIPE信号。

管道本身拥有一个容量限制,大小默认是65535字节。可以使用fcntl来修改。

此外,socket的基础api种有一个socketpari函数。用以方便地创建双向管道:

1 2 3 #include <sys/types.h> #include <sys/socket.h> int socketpair (int domain, int type, int protocol, int fd[2 ]) ;

前三个参数和socket的参数完全相同,但domain只能使用UNIX本地域协议族AF_UNIX,因为仅能在本地使用。

6.2 dup函数和dup2函数 重定向文件描述符,比如将标准输入重定向到一个文件。可以通过如下用于复制文件描述符的dup/dup2函数实现:

1 2 3 #include <unistd.h> int dup (int file_descriptor) ;int dup2 (int file_descriptor_one, int file_descriptor_two) ;

利用函数实现一个基本GGI服务器例子:

1 2 3 4 5 6 7 8 9 10 11 12 13 14 15 16 17 18 19 20 21 22 23 24 25 26 27 28 29 30 31 32 33 34 35 36 37 38 39 40 41 42 43 44 45 46 47 48 49 50 #include <sys/socket.h> #include <netinet/in.h> #include <arpa/inet.h> #include <assert.h> #include <stdio.h> #include <unistd.h> #include <stdlib.h> #include <errno.h> #include <string.h> int main ( int argc, char *argv[] ) { if ( argc<=2 ) { printf ("usage: ...." ); return 1 ; } const char *ip = argv[1 ]; int prot = atoi( argv[2 ] ); struct sockaddr_in address ; bzero( &address, sizeof ( address ) ); address.sin_family = AF_INET; inet_pton( AF_INET, ip, &address.sin_addr ); address.sin_port = htons( port ); int sock = socket( AF_INET, SOCK_STREAM, 0 ); assert( sock>=0 ); int ret = bind( sock, (struct sockaddr*)&address, sizeof ( address ) ); assert( ret!=-1 ); ret = listen( sock, 5 ); assert( ret!=-1 ); struct sockaddr_in client ; socklen_t cli_len = sizeof ( client ); int connfd = accept( sock, (struct sockaddr*)&client, &cli_len ); if ( connfd<0 ) { printf ( "errno is: %d\n" , errno ); } else { close( STDOUT_FILENO ); dup( connfd ); printf ( "abcd\n" ); close( connfd ); } close( sock ); return 0 ; }

首先关闭标准输出,此时dup的特性,返回最小可用的文件描述符,即此时标志输出被重定向到connfd,此时的printf将直接发送到connfd连接的socket上。

6.3 readv函数和writev函数 集中写和分散读函数:

1 2 3 #include <sys/uio.h> ssize_t readv (int fd, const struct iovec *vector , int count) ;ssize_t writev (int fd, const struct iovec *vector , int count) ;

考略之前的Web服务器,当Web服务器解析完一个HTTP请求后,如果目标文档存在且客户具有读权限,那么就要发送一个HTTP应答。这个HTTP应答包含一个状态行,多个头部字段,一个空行和文档的内容,前三部分内容可能存放在一块内存,文档的内容则在另一块单独的内存,此时可以用集中写,将他们一起写出。

1 2 3 4 5 6 7 8 9 10 11 12 13 14 15 16 17 18 19 20 21 22 23 24 25 26 27 28 29 30 31 32 33 34 35 36 37 38 39 40 41 42 43 44 45 46 47 48 49 50 51 52 53 54 55 56 57 58 59 60 61 62 63 64 65 66 67 68 69 70 71 72 73 74 75 76 77 78 79 80 81 82 83 84 85 86 87 88 89 90 91 92 93 94 95 96 97 98 99 100 101 102 103 104 105 106 107 108 109 110 111 112 113 114 115 #include <sys/socket.h> #include <netinet/in.h> #include <arpa/inet.h> #include <assert.h> #include <stdio.h> #include <unistd.h> #include <stdlib.h> #include <errno.h> #include <string.h> #include <sys/stat.h> #include <fcntl.h> #icnlude <sys/types.h> #define BUFFER_SZIE 1024 static const char *status_line[2 ] = { "200 ok" , "500 Internal server error" };int main ( int argc, char *argv[] ) { if ( argc<=3 ) { printf ( "usage: ... " ); return 1 ; } const char *ip = argv[1 ]; int port = atoi( argv[2 ] ); const char *file_name = argv[3 ]; struct sockaddr_in address ; bzero( &address, sizeof ( address ) ); address.sin_family = AF_INET; inet_pton( AF_INET, ip, &address.sin_addr ); address.sin_port = htons( port ); int sock = socket( AF_INET, SOCK_STREAM, 0 ); assert( sock>=0 ); int ret = bind( sock, (struct sockaddr*)&address, sizeof ( address ) ); assert( ret!=-1 ); ret = listen( sock, 5 ); assert( ret!=-1 ); struct sockaddr_in client ; socklen_t cli_len = sizeof ( client ); int connfd = accept( sock, (struct sockaddr*)&client, &cli_len ); if ( connfd<0 ) { printf ( "errno is: %d\n" , errno ); } else { char header_buf[BUFFER_SIZE]; memset ( header_buf, '\0' , BUFFER_SIZE ); char *file_buf; struct stat file_stat ; bool valid = true ; int len = 0 ; if ( stat( file_name, &file_stat) < 0 ) { valid = false ; } else { if ( S_ISDIR( file_stat.st_mode ) ) { valid = false ; } else if ( file_stat.st_mode & S_IROTH ) { int fd = open( file_name, O_RDONLY ); file_buf = new char [file_stat.st_size + 1 ]; memset ( file_buf, '\0' , file_stat.st_size + 1 ); if ( read( fd, file_buf, file_stat.st_size ) < 0 ) { valid = false ; } } else { valid = false ; } } if ( valid ) { ret = snprintf ( header_buf, BUFFER_SIZE-1 , "%s %s\r\n" , "HTTP/1.1" , status_line[0 ] ); len+=ret; ret = snprintf ( header_buf+len, BUFFER_SIZE-1 -len, "Content-Length: %d\r\n" , file_stat.st_size ); len+=ret; ret = snprintf ( header_buf+len, BUFFER_SIZE-1 -len, "%s" , "\r\n" ); struct iovec iv [2]; iv[0 ].iov_base = header_buf; iv[0 ].iov_len = strlen ( header_buf ); iv[1 ].iov_base = file_buf; iv[1 ].iov_len = file_stat.st_size; ret = writev( connfd, iv, 2 ); } else { ret = snprintf ( header_buf, BUFFER_SIZE-1 , "%s %s\r\n" , "HTTP/1.1" , status_line[1 ] ); len+=ret; ret = snprintf ( header_buf+len, BUFFER_SIZE-1 -len, "%s" , "\r\n" ); send( connfd, header_buf, strlen ( header_buf ), 0 ); } close( connfd ); delete [] file_buf; } close( sock ); return 0 ; }

6.4 sendfile函数 sendfile在两个文件描述符之间直接传递数据,完全在内核种操作,避免了内核缓存区和用户缓冲区之间的数据拷贝,效率很高,被称为零拷贝。

1 2 #include <sys/sendfile.h> ssize_t sendfile (int out_fd, int in_fd, off_t *offset, size_t count) ;

in_fd是待读出内容的文件描述符,out_fd是待写入内容的文件描述符,offset为读入文件流的偏移位置,count为拷贝字节数。

1 2 3 4 5 6 7 8 9 10 11 12 13 14 15 16 17 18 19 20 21 22 23 24 25 26 27 28 29 30 31 32 33 34 35 36 37 38 39 40 41 42 43 44 45 46 47 48 49 50 51 52 53 54 55 56 57 58 59 #include <sys/socket.h> #include <netinet/in.h> #include <arpa/inet.h> #include <assert.h> #include <stdio.h> #include <unistd.h> #include <stdlib.h> #include <errno.h> #include <string.h> #include <sys/stat.h> #include <fcntl.h> #icnlude <sys/types.h> #include <sys/sendfile.h> int main ( int argc, char *argv[] ) { if ( argc<=3 ) { printf ("usage: ... " ); return 1 ; } const char *ip = argv[1 ]; int prot = atoi( argv[2 ] ); const char *file_name = argv[3 ]; int filefd = open( file_name, O_RDONLY ); assert( filefd>0 ); struct stat stat_buf ; fstat( filfd, &stat_buf ); struct sockaddr_in address ; bzero( &address, sizeof ( address ) ); address.sin_family = AF_INET; inet_pton( AF_INET, ip, &address.sin_addr ); address.sin_port = htons( port ); int sock = socket( AF_INET, SOCK_STREAM, 0 ); assert( sock>=0 ); int ret = bind( sock, (struct sockaddr*)&address, sizeof ( address ) ); assert( ret!=-1 ); ret = listen( sock, 5 ); assert( ret!=-1 ); struct sockaddr_in client ; socklen_t cli_len = sizeof ( client ); int connfd = accept( sock, (struct sockaddr*)&client, &cli_len ); if ( connfd<0 ) { printf ( "errno is: %d\n" , errno ); } else { sendfile( connfd, filefd, NULL , stat_buf.st_size ); close( connfd ); } close( sock ); return 0 ; }

6.5 mmap函数和munmap函数 mmap函数用于申请一段内存空间。可用将这段内存作为进程间通信的共享内存,也可以直接将文件映射到其中。mumap函数则释放mmap创建的这段内存:

1 2 3 #include <sys/mman.h> void *mmap (void *start, size_t length, int prot, int flags, int fd, off_t offset) ;int munmap (void *start, size_t length) ;

start参数允许用户使用某个特定的地址作为其实地址,设置为NULL,则系统自动分配一个地址。prot参数用来设置内存段的访问权限,可取以下几个值的按位或:

PROT_READ,内存段可读。

PROT_WRITE,内存段可写。

PROT_EXEC,内存段可执行。

PROT_NONE,内存段不能被访问。

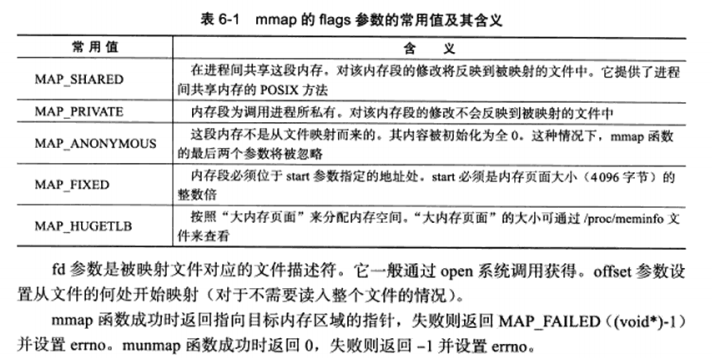

flags参数控制内存段内容被修改后程序的行为。如下表,其中MAP_SHARED和MAP_PRIVATE是互斥的,不能同时指定:

6.6 splice函数 splice函数用于在两个文件描述符之间移动数据,也是零拷贝操作。

1 2 3 #include <fcntl.h> ssize_t splice (int fd_in, loff_t *off_in, int fd_out, loff_t *off_out, size_t len, unsigned int flags) ;

fd_in是待输入数据的文件描述符。

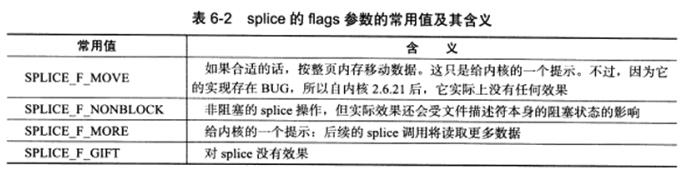

flags参数的常用值:

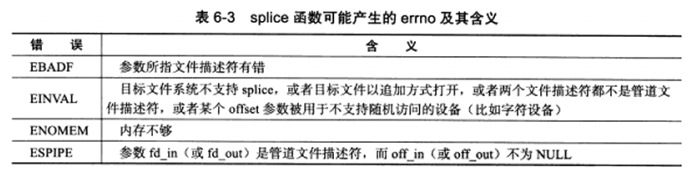

使用splice函数时,fd_in和fd_out必须至少有一个时管道文件描述符。splice函数常见的errno如下:

1 2 3 4 5 6 7 8 9 10 11 12 13 14 15 16 17 18 19 20 21 22 23 24 25 26 27 28 29 30 31 32 33 34 35 36 37 38 39 40 41 42 43 44 45 46 47 48 49 50 51 52 53 54 55 56 57 58 59 #include <sys/socket.h> #include <netinte/in.h> #include <arpa/inet.h> #inlcude <assert.h> #include <stdio.h> #include <unistd.h> #include <stdlib.h> #include <string.h> #include <errno.h> #include <fcntl.h> int main ( int argc, char *argv[] ) { if ( argc<=2 ) { printf ("usage: ... " ); return 1 ; } const char *ip = argv[1 ]; int port = atoi( argv[2 ] ); struct sockaddr_in address ; bzero( &address, sizeof ( address ) ); address.sin_family = AF_INET; inet_pton( AF_INET, ip, &address.sin_addr ); address.sin_port = htons( port ); int sock = socket( AF_INET, SOCK_STREAM, 0 ); assert( sock>=0 ); int ret = bind( sock, (struct sockaddr*)&address, sizeof ( address ) ); assert( ret!=-1 ); ret = listen( sock, 5 ); assert( ret!=-1 ); struct sockaddr_in client ; socklen_t cli_len = sizeof ( client ); int connfd = accept( sock, (struct sockaddr*)&client, &cli_len ); if ( connfd<0 ) { printf ( "errno is: %d\n" , errno ); } else { int pipefd[2 ]; assert( ret != -1 ); ret = pipe( pipefd ); ret = splice( connfd, NULL , pipefd[1 ], NULL , 32768 , SPLICE_F_MORE | SPLICE_F_MOVE ); assert( ret != -1 ); ret = splice( pipifd[0 ], NULL , connfd, NULL , 32768 , SPLICE_F_MORE | SPLICE_F_MOVE ); assert( ret != -1 ); close( connfd ); } close( sock ); return 0 ; }

6.7 tee函数 tee函数在两个管道文件描述符之间复制数据,也是零拷贝操作。

1 2 #include <fcntl.h> ssize_t tee (int fd_in, int fd_out , size_t len, unsigned int flags) ;

参数和splice一致,但fd_in和fd_out必须都是管道。

1 2 3 4 5 6 7 8 9 10 11 12 13 14 15 16 17 18 19 20 21 22 23 24 25 26 27 28 29 30 31 32 33 34 35 36 37 38 39 40 41 42 43 44 #include <assert.h> #include <stdio.h> #include <unistd.h> #include <errno.h> #include <string.h> #include <fcntl.h> int main ( int argc, char *argv[] ) { if ( argc !=2 ) { printf ("usage: ... " ); return 1 ; } int filefd = open( argv[1 ], O_CREAT | O_WRONLY | O_TRUNC, 0666 ); assert( filefd>0 ); int pipefd_stdout[2 ]; int ret = pipe( pipefd_stdout ); assert( ret!=-1 ); ret = splice( STDIN_FILENO, NULL , pipefd_stdout[1 ], NULL , 32768 , SPLICE_F_MORE | SPLICE_F_MOVE ); assert( ret!=-1 ); ret = tee( pipefd_stdout[0 ], pipefd_file[1 ], 32768 , SPLICE_F_NONBLOCK ); assert( ret!=-1 ); ret = splice( pipefd_file[0 ], NULL , filefd, NULL , 32768 , SPLICE_F_MORE | SPLICE_F_MOVE ); assert( ret !=-1 ); ret = splice( pipefd_stdout[0 ], NULL , STDOUT_FILENO, NULL , 32768 , SPLICE_F_MORE | SPLICE_F_MOVE ); assert( ret!=-1 ); close( filefd ); close( pipefd_stdout[0 ] ); close( pipefd_stdout[1 ] ); close( pipefd_file[0 ] ); close( pipefd_file[1 ] ); return 0 ; }

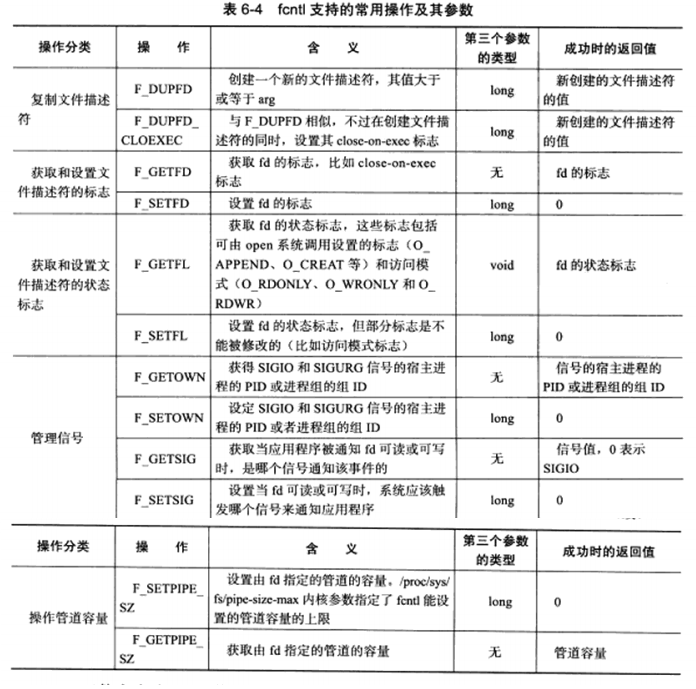

6.8 fcntl函数 1 2 #include <fcntl.h> int fcntl (int fd, int cmd, ...) ;

支持的常用操作如下表:

1 2 3 4 5 6 7 8 int setnonblocking (int fd) { int old_option = fcntl( fd, F_GETFL ); int new_option = old_option | O_NONBLOCK; fcntl( fd, F_SETFL, new_option ); return old_option; }

第7章 Linux服务器程序规范 服务器程序的常见模板:

以守护进程运行,拥有一套日志系统,以某个专门的非root身份运行,通常可配置的也就是拥有配置文件,通常会在启动的时候生成一个PID文件并存入/var/run目录,通常需要考虑系统资源和限制。

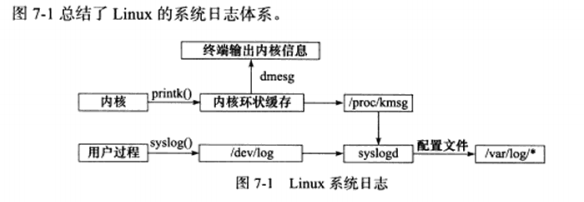

7.1 日志 a) Linux系统日志

Linux提供一个守护进程来处理系统日志——syslogd,现在使用的为它的升级版——rsyslogd。

分为内核输出的日志和用户输出的日志。

内核:由printk等函数打印至内核的环状缓存(ring buffer)中。环状缓存的内容直接映射到/proc/ kmsg文件中。

用户:通过调用syslog函数生成系统日志,该函数将日志输出到一个UNIX本地域socket类型的文件/dev/log中,rsyslogd则监听该文件以获取用户进程的输出。

rsylogd守护进程在接收到用户进程或内核输入的日志后,会把它们输出至某些特定的日志文件。默认情况下,调式信息会保存至/var/log/debug文件,普通信息/var/log/message文件,内核消息/var/log/kern/loh文件。日志信息具体如何分发,可在rsyslogd的配置文件中设置。

b) syslog函数

应用程序使用syslog函数与rsylogd守护进程通信:

1 2 #include <syslog.h> void syslog (int priority, const char *message, ...) ;

priority参数是所谓的设施值与日志级别的按位或。设施值的默认值是LOG_USER,下面的讨论仅限于该值。日志级别如下:

1 2 3 4 5 6 7 8 9 #include <syslog.h> #define LOG_EMERG 0 #define LOG_ALERT 1 #define LOG_CRIT 2 #define LOG_ERR 3 #define LOG_WARNING 4 #define LOG_NOTICE 5 #define LOG_INFO 6 #define LOG_DEBUG 7

下面这个函数可改变syslog的默认输出方式,进一步结构化日志内容:

1 2 #include <syslog.h> void openlog (const char *ident, int logopt, int facility) ;

ident参数指定的字符串将被添加到日志消息的日期和时间之后,它通常被设置为程序的名字。logopt参数对后续syslog调用的行为进行配置,它可取下列值的按位或:

1 2 3 4 #define LOG_PID 0X01 #define LOG_CONS 0X02 #define LOG_ODELAY 0X04 #define LOG_NDELAY 0X08

facility参数可用来修改syslog函数中的默认值。

下面这个函数用于设置syslog的日志掩码:

1 2 #include <syslog.h> int setlogmask (int maskpri) ;

如下函数关闭日志功能:

1 2 #include <syslog.h> void closelog () ;

7.2 用户信息 a) UID, EUID, GID 和 EGID

下面这一组函数可用获取和设置当前进程的真实用户ID(UID),有效用户ID(EUID),真实组(GID)和有效组(EGID):

1 2 3 4 5 6 7 8 9 10 #include <sys/types.h> #include <unistd.h> uid_t getuid () ; uid_t seteuid () ;gid_t getgid () ;gid_t getegid () ;int setuid (uid_t uid) ;int seteuid (uid_t uid) ;int setgid (gid_t gid) ;int setegid (gid_t gid) ;

测试进程的UID和EUID的区别:

1 2 3 4 5 6 7 8 9 #include <unistd.h> #include <stdio.h> int main () { uid_t uid = getuid(); uid_t euid = geteuid(); printf ( "userid is %d, effectie userid is %d\n" , uid, euid ); return 0 ; }

编译该文件,将生成的可执行文件(test_uid)的所有者设置为roort,并设置该文件的set-user-id标志,然后运行该程序查看UID和EUID:

1 2 3 4 $ sudo chown root:root test_uid $ sudo chmod +s test_uid $ ./test_uid userid is 1000 , effective userid is 0

可看出进程的UID是启动用户的ID,而EUID则是root账户的ID

b) 切换用户

1 2 3 4 5 6 7 8 9 10 11 12 13 14 15 16 17 18 19 20 21 22 23 24 25 26 27 28 static bool switch_to_user (uid_t user_id, gid_t gp_id) { if ( ( user_id == 0 ) && (gp_id == 0 ) ) { return false ; } gid_t gid = getgid(); uid_t uid = getuid(); if ( ( (gid != 0 ) || (uid != 0 ) ) && ( (gid != gp_id ) || ( uid != user_id ) ) ) { return false ; } if ( uid != 0 ) { return true ; } if ( ( setgid( gp_id ) < 0 ) || ( setuid( user_id ) < 0 ) ) { return false ; } return true ; }

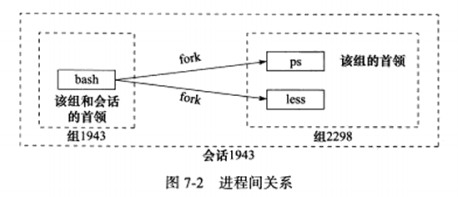

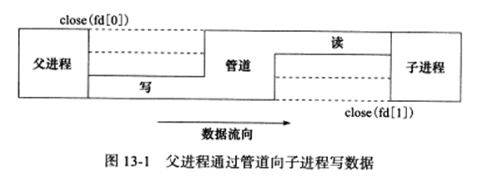

7.3 进程间关系 a) 进程组

每个进程都属于一个进程组,除了它们的PID信息外,还有进程组ID(PGID):

1 2 #included <unistd.h> pid_t getpgid (pid_t pid) ;

每个进程都有一个首领进程,其PGID和PID相同。进程组将一直存在,直到其中所有进程都退出或加入其他的进程组。

下面的函数用于设置PGID:

1 2 #include <unistd.h> int setpgid (pid_t pid, pid_t pgid) ;

将PID为pid的进程的PGID设置为pgid,如果pid和pgid相同,则由pid指定的进程将被设置为进程组首领。如果pid为0,则表示设置当前进程的PGID为pgid,如果pgid为0,则使用pid作为目标PGID。

b) 会话

一些有关联的进程组将形成一个会话,下面的函数用于创建一个会话:

1 2 #include <unistd.h> pid_t setsid (void ) ;

该函数不能由进程组的首领进程调用,否则将产生一个错误。对于非组首领的进程,调用函数不仅创建新会话,而且有如下额外效果:

调用进程成为会话的首领,此时该进程是新会话的唯一成员。

新建一个进程组,其GPID就是调用进程的PID,调用进程成为改组的首领。

调用进程将甩开终端。

如下函数读取会话ID(SID):

1 2 #include <unistd.h> pid_t getsid (pid_t pid) ;

c) 用ps命令查看进程关系

1 2 3 4 5 $ ps -o pid,ppid,pgid,sid,comm | less PID PPID PGID SID COMMAND 1943 1942 1943 1943 bash2298 1943 2298 1943 ps2299 1942 2298 1943 less

三者关系如下图:

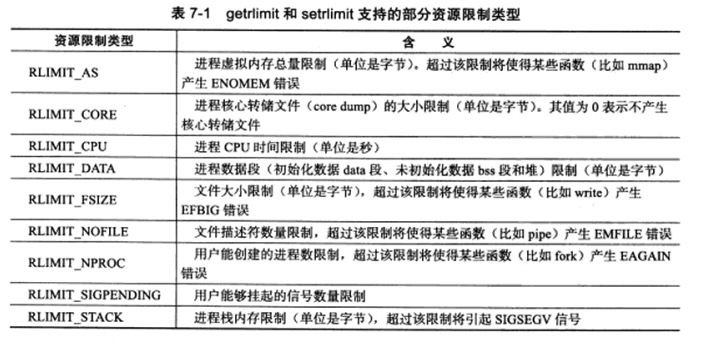

7.4 系统资源限制 Linux系统资源限制可用通过如下一对函数来读取和设置:

1 2 3 4 5 6 7 8 #include <sys/resuorce.h> int getrlimit (int resource, struct rlimit *rlim) ;int setrlimit (int resource, const struct rlimit *rlim) ;struct rlimit { rlim_t rlim_cur; rlim_r rlim_max; }

rlim_cur指定资源的软限制,rlim_max指定资源的硬限制。软限制是一个建议性的,最好不要超越的限制,如果超越的话,系统可能向进程发送信号以终止其运行。硬限制一般是软限制的上限,普通程序可减小硬限制,而只有root身份运行的程序才能增加硬限制。下图列举了部分比较重要的资源限制类型:

7.5 改变工作目录和根目录 有的服务器程序需要改变工作目录。如前面讨论的Web服务器。

获取当前工作目录和改变进程工作目录的函数分别是:

1 2 3 #include <unistd.h> char *getcwd (char *buf, size_t size) ;int chdir (const char *path) ;

改变进程根目录的函数是chroot,其定义如下:

1 2 #include <unistd.h> int chroot (const char *path) ;

chroot并不改变进程的当前工作目录,所以调用chroot之后,我们仍然需要使用chdir(“/“)来将工作目录切换至新的根目录。此外,只有特权进程才能改变根目录。

7.6 服务器程序后台化 讨论在代码中如何让一个进程以守护进程的方式运行。

1 2 3 4 5 6 7 8 9 10 11 12 13 14 15 16 17 18 19 20 21 22 23 24 25 26 27 28 29 30 31 32 33 34 35 36 37 38 bool daemonize () { pid_t pid = fork(); if ( pid < 0 ) { return false ; } else if ( pid > 0 ) { exit (0 ); } umask( 0 ); pid_t sid = setsid(); if ( sid < 0 ) { return false ; } if ( ( chdir( "/" ) ) < 0 ) { return false ; } close( STDIN_FILENO ); close( STDOUT_FILENO ); close( STDERR_FILENO ); . . . . . . open( "dev/null" , O_RDONLY ); open( "dev/null" , O_RDWR ); open( "dev/null" , O_RDWR ); return true ; }

Linux提供了完成同样功能的库函数:

1 2 #include <unistd.h> int daemon (int nochdi, int noclose) ;

nochdir参数用于指定是否改变工作目录,为0则设置为”/“,否则继续使用当前。

nclose参数为0时,标准输入,输出,错误都被重定向到/dev/null文件,否则依然使用原来的设备。

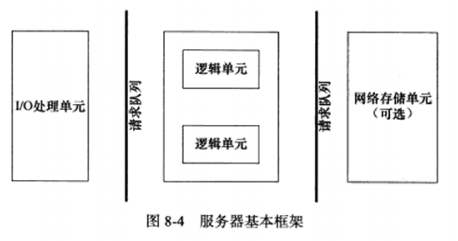

第8章 高性能服务器程序框架 按照服务器程序的一般原理,将服务器解构成三个模块:

I/O处理单元,逻辑单元,存储单元。

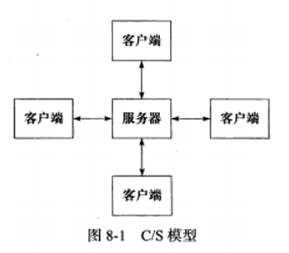

8.1 服务器模型 a) CS模型

最常见的客户端,服务端模型。

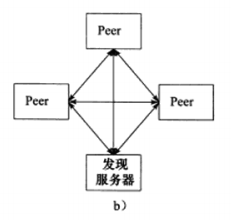

b) P2P模型

摒弃了以服务器为中心的格局,网络上所有主机重新回归对等的地位。

P2P模型使得每台机器在消耗服务的同时也能给别人提供服务,这样资源能够充分,自由地共享。P2P模型存在一个显著的问题,即主机之间很难互相发现。所以实际使用的P2P模型通常带有一个专门的发现服务器,提供查找服务,使每个客户能尽快的找到自己需要的资源。

8.2 服务器编程框架 基本框架如下:

模块

单个服务器程序

服务器机群

I/O处理单元

处理客户连接,读写网络数据

作为接入服务器,实现负载均衡

逻辑单元

业务进程或线程

逻辑服务器

网络存储单元

本地数据库,文件或缓存

数据库服务器

请求队列

各单元之间的通信方式

各服务器之间的永久TCP连接

请求队列是各个单元之间通信方式的抽象,I/O处理单元接收到客户请求时,需要以某种方式通知一个逻辑单元来处理该请求。请求队列通常被实现为池的一部分。

8.3 I/O模型 I/O模型对比:

I/O模型

读写操作和阻塞阶段

阻塞I/O

程序阻塞于读写函数

I/O复用

程序阻塞于I/O复用系统调用(如select),但可同时监听多个I/O事件。对I/O本身的读写操作是非阻塞的

SIGIO信号

信号触发读写就绪事件,用户程序执行读写操作。程序没有阻塞阶段

异步I/O

内核执行读写操作并触发读写完成事件。程序没有阻塞阶段

针对非阻塞I/O执行的系统调用总是立即返回,而不管事件是否已经发生。如果没有立即发生,返回-1和出错的情况一样。此时需要根据errno来区分这两种情况。

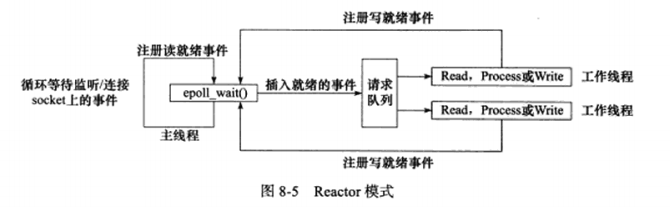

8.4 两种高效的事件处理模式 同步I/O常用于实现Reactor模式,异步I/O则用于实现Proactor模式。

a) Reactor模式

该模式,要求主线程(I/O处理单元)只负责监听文件描述符是否有事件发生,有的话立即将该事件通知工作线程(逻辑单元)。除此之外,主线程不做任何其他实质性的工作。读写数据,接受新的连接,以及处理客户请求均在工作线程完成。

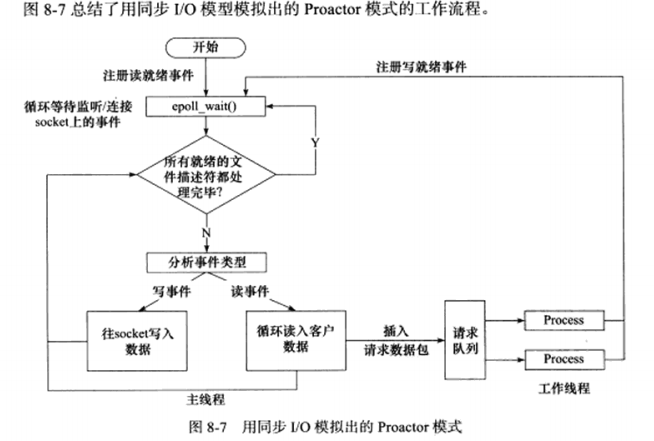

使用同步I/O模型(epoll_wait)实现的的Reactor模型流程如下:

主线程往epoll内核事件表中注册socket上的读就绪事件。

主线程调用epoll_wait等待socket上有数据可读。

当socket可读时,epoll_wait通知主线程。主线程则将socket可读事件放入请求队列。

睡眠在请求队列上的工作线程被唤醒,它从socket读取数据,并处理客户请求,然后往epoll内核事件表注册该socket的写就绪事件。

主线程调用epoll_wait等待socket可写。

当socket可写时,epoll_wait通知主线程。主线程则将socket可写事件放入请求队列。

睡眠在请求队列上的工作线程被唤醒,它往socket上写入服务器处理客户请求的结果。

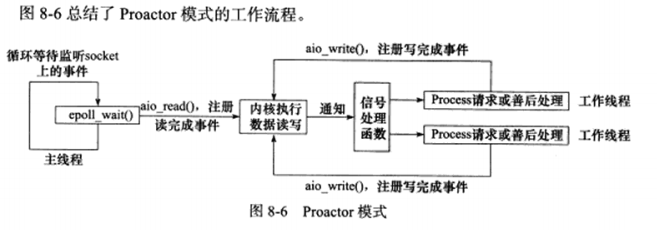

b) Proactor模式

Proactor模式将所有的I/O操作交给主线程和内核来处理,工作线程仅负责业务逻辑。因此,该模式更符合前面所描述的服务器编程框架。

使用异步I/O模型(以aio_read和aio_write为例)实现的Proactor模式的流程如下:

主线程调用aio_read函数向内核注册socket上的读完成事件,并告诉内核用户读缓冲区的位置,以及读操作完成时如何通知应用程序(这里以信号为例)。

主线程继续处理其他逻辑。

当socket上的数据被读入用户缓冲区后,内核向应用程序发送一个信号,以通知应用程序数据已经可用。

应用程序预先定义好的信号处理函数选择一个工作线程来处理该客户请求。工作线程处理完客户请求后,调用aio_write函数向内核注册该socket上的写完成事件,并告诉内核用户写缓冲区的位置,以及写操作完成时如何通知应用程序。

主线程继续处理其他逻辑。

当用户缓冲区的数据被写入socket之后,内核向应用程序发送一个信号,通知应用程序数据已发送完毕。

应用程序预先定义好的信号处理函数选择一个工作线程来做善后处理,比如是否关闭socket

c) 模拟Proactor模式

使用同步I/O方式模拟出Proactor模式的一种方法。简单来说将数据读写操作这一工作,从逻辑单元移交给I/O处理单元,读写完成后,主线程向工作线程通知这一”完成事件”。

使用同步I/O模型(epoll_wait)模拟出的Proactor模式的流程如下:

主线程往epoll内核事件表注册socket上的读就绪事件。

主线程调用epoll_wait等待socket上有数据可读。

当socket上有数据可读时,epoll_wait通知主线程。主线程从socket循环读取数据,读完后,将读到的数据封装成一个请求对象并插入请求队列。

睡眠在请求队列上的某个工作线程被唤醒,它获得请求对象并处理该客户请求,然后往epoll内核事件表中注册该socket上的写就绪事件。

主线程调用epoll_wait等待socket可写。

当socket可写时,epoll_wati通知主线程。主线程往socket上写入服务器处理客户请求的结果。

8.5 两种高效的并发模式 并发编程的目的简单来说为了提高程序的效率。对于计算密集型来说,并发没有优势,反而因为任务的切换使得效率降低。但对于I/O密集型,比如经常读写文件,访问数据库。由于I/O操作的速度远没有CPU的计算速度快,让程序阻塞于I/O操作将浪费大量的CPU事件。因此,并发可使CPU的利用率显著提升。

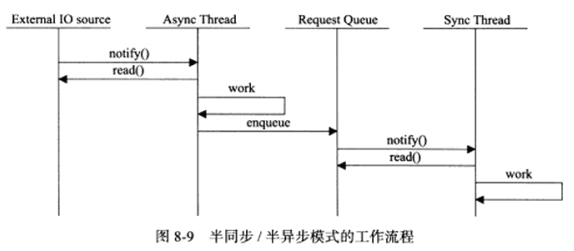

并发模式是指I/O处理单元和多个逻辑单元之间协调完成任务的方法。服务器主要有两种并发编程模式:半同步/半异步(half-sync/half-async)模式和领导者/追随者(Leader/Followers)模式。

a) 半同步/半异步模式

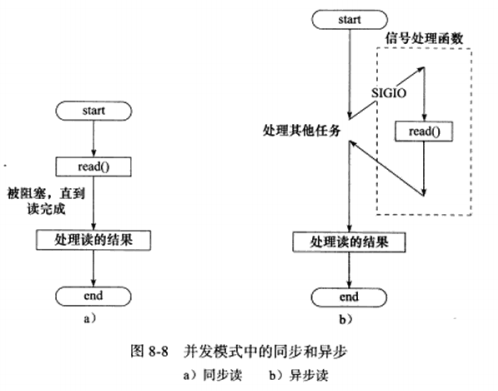

此处的同步/异步和I/O模型中的同步/异步是完全不同的概念。

I/O模型:同步和异步区分的是内核向应用程序通知的是何种I/O事件(就绪事件 or 完成事件),以及由谁来完成I/O读写(应用程序 or 内核)。

并发模式:同步是指程序完全按照代码序列的顺序执行,异步是指程序的执行需要由系统事件来驱动。常见的系统事件包括中断,信号等。

下图a描述了同步的读操作,b描述了异步的读操作:

按同步方式运行的线程称为同步线程,异步方式则称为异步线程。异步效率高,复杂;同步效率低,简单。

同步线程用于处理客户逻辑,即逻辑单元;异步线程处理I/O事件,即I/O处理单元。

异步线程监听到客户请求后,将其封装成请求对象插入请求队列。请求队列通知某个工作在同步模式的工作线程来读取并处理该请求对象。

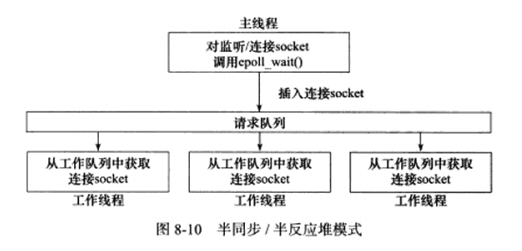

半同步/半异步模式的变体,半同步/半反应堆模式:

异步线程只有主线程,主线程插入请求队列的任务是就绪的连接socket。这说明改图采用的事件处理模式是Reactor模式:它要求工作线程自己从socket上读取客户请求和往socket写入服务器应答。这也是该模式半反应堆的含义。该模式存在如下缺点:

主线程和工作线程共享请求队列。主线程往请求队列中添加任务,或者工作线程从请求队列中取出任务,都需要对请求队列加锁保护,从而耗费CPU时间。

每个工作线程在同一时间只能处理一个客户请求。如果客户数量较多,工作线程较少,请求队列中任务对象越堆越多,客户端响应速度将越来越慢。

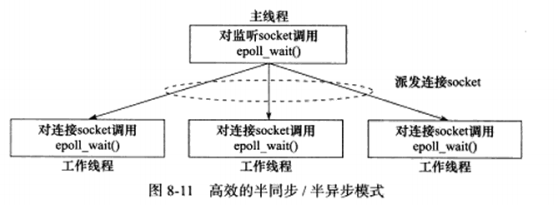

下图描述了一种相对高效的半同步/半异步模式:

主线程只管监听socket,连接socket由工作线程来管理,此后该新socket上的任何I/O操作都由被选中的工作线程来处理,直到客户关闭连接。

可见每个线程都维持自己的事件循环,它们各自独立地监听不同的事件。

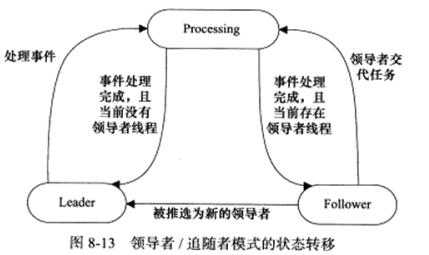

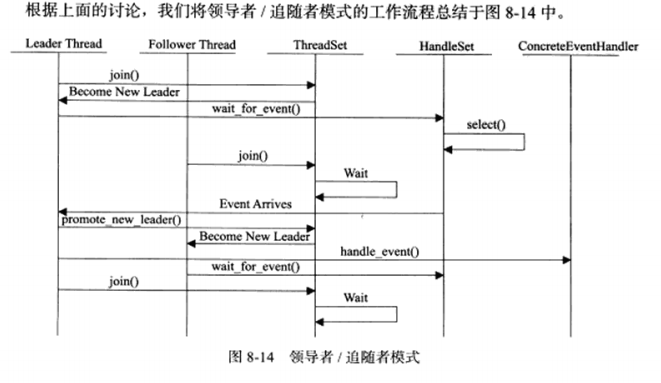

b) 领导者/追随者模式

该模式是多个工作线程轮流获得事件源集合,轮流监听,分发并处理事件的一种模式。任何时间,程序仅有一个领导者,它负责监听I/O事件。当前领导者如果检测到I/O事件,首先从线程池中推选出新的领导者线程,然后处理I/O事件。此时,新的领导者等待新的I/O事件,原先的领导者则处理I/O事件。

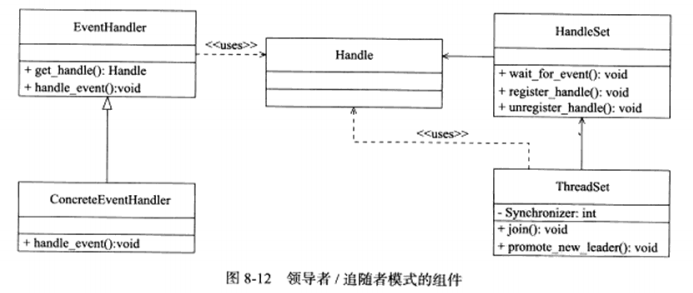

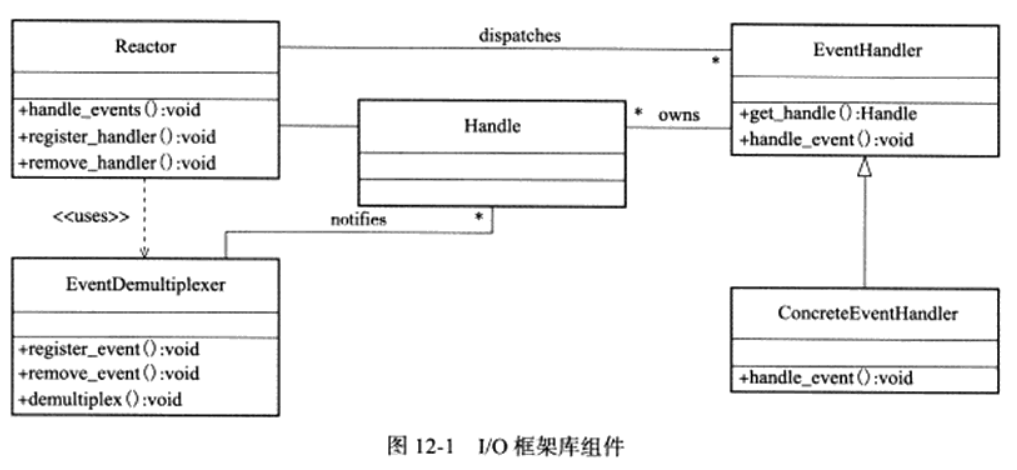

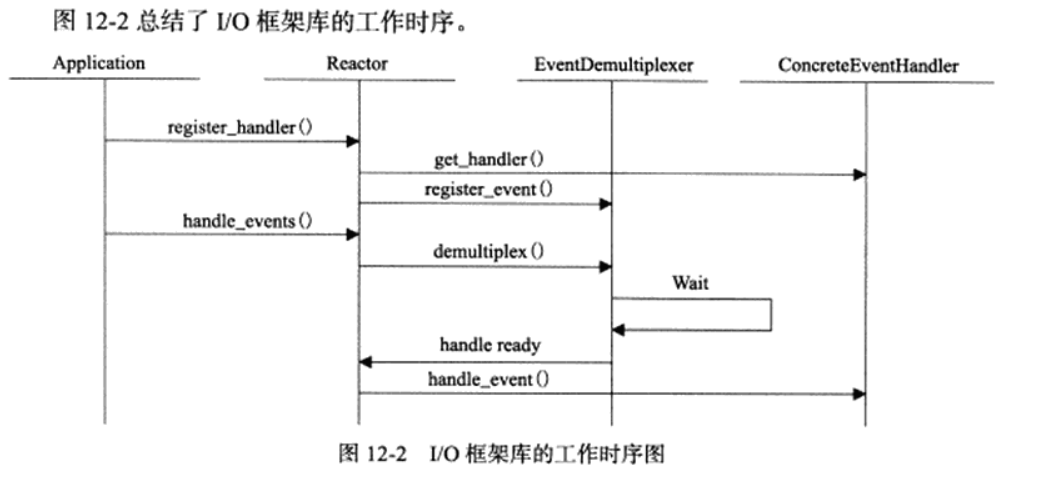

领导者/追随者模式包含如下几个组件:句柄集(HandleSet),线程集(ThreadSet),事件处理器(EventHandler)和具体的事件处理器(ConcreteEventHandler)。

1.句柄集 :

句柄用于表示I/O资源,句柄集管理众多句柄,它使用waif_for_event方法来监听句柄上的I/O事件,并将其中的就绪事件通知给领导者线程。领导者则调用绑定在Handle上的事件处理器来处理事件。领导者将Handle和事件处理器绑定是通过调用句柄集中的register_handle方法实现的。

2.线程集:

所有工作线程的管理者,负责各线程之间的同步,以及新领导者线程的推选,任一线程必处于如下三种状态之一:

Leader:线程当前处于领导者线程,负责等待句柄集上的I/O事件。

Processing:线程正在处理事件。领导者检测到I/O之间之后,转移到该状态来处理事件,并调用promote_new_leader方法推选新的领导者;也可以指定其他追随者来处理时间,此时领导者地位不变。当处于Processing状态的线程处理完后,如果没有领导者,它将称为领导者,反之称为追随者。

Follower:线程当前处于追随者身份。通过调用join方法等待称为新的领导者,也可能被领导指定处理新任务。

3.事件处理器和具体的事件处理器

事件处理器通常包含一个或多个回调函数handle_event。这些回调函数用于处理事件对应的业务逻辑。事件处理器在使用之前需要被绑定到某个句柄之上。具体的事件处理器是事件处理器的派生类。它们必须重新实现基类的handle_event方法,以处理特定的任务。

由于领导者线程自己监听I/O并处理客户请求,因此不需要在线程之间传递任何额外的数据,也无需像半同步/半反应堆那样在线程之间同步堆请求队列的访问。

8.6 有限状态机 此节介绍逻辑单元内部的一种高效编程方法:有限状态机

有的应用层协议头部包含数据包类型字段,每种类型可以映射为逻辑单元的一种执行状态,服务器可以根据它来编写相应的处理逻辑,如下。

1 2 3 4 5 6 7 8 9 10 11 12 STATE_MACHINE ( Package_pack ) { PackageType _type = _pack.GetType(); switch ( _type ) { case type_A: process_package_A( _pack ); break ; case type_B: process_package_B( _pack ); break ; } }

这就是一个简单的有限状态机,但每个状态都是相互独立的,之间没有相互转移。状态之间的转移是需要状态机内部驱动的,如下。

1 2 3 4 5 6 7 8 9 10 11 12 13 14 15 16 17 STATE_MACHINE () { State cur_State = type_A; while ( cur_State != type_C) { package _pack = getNewPackage(); switch ( cur_State ) { case type_A: process_package_state_A( _pack ); cur_State = type_B; break ; case type_B: process_package_state_B( _pack ); cur_State = type_C; break ; } } }

该状态机包含三种状态:type_A,type_B,type_C,A为开始状态,C为结束状态,通过curState判断以及给他传递状态值实现状态转移。

下面考虑有限状态机应用的一个实例:*HTTP请求的读取和分析 *。

很多网络协议,在头部提供长度字段,根据该字段的值可以直到是否接收到一个完整的协议头部。但HTTP协议并未提供这样的头部长度字段,并且头部长度变化很大。根据协议规定,我们判断HTTP头部结束的依据是遇到一个空行,该空行仅包含一对回车换行符()。

如果一次读操作没有读入HTTP请求的整个头部,即没有遇到空行,那么我们需要等待客户继续写数据并再次读入。因此我们每完成一次读操作,需要分析新读入的数据中是否有空行。不过在寻找空行的过程中,我们可以同时完成对整个HTTP请求头部的分析(空行前面还有请求行和头部域),以提高HTTP请求的效率。

如下代码使用主,从两个有限状态机实现了最简单的HTTP请求的读取和分析。

1 2 3 4 5 6 7 8 9 10 11 12 13 14 15 16 17 18 19 20 21 22 23 24 25 26 27 28 29 30 31 32 33 34 35 36 37 38 39 40 41 42 43 44 45 46 47 48 49 50 51 52 53 54 55 56 57 58 59 60 61 62 63 64 65 66 67 68 69 70 71 72 73 74 75 76 77 78 79 80 81 82 83 84 85 86 87 88 89 90 91 92 93 94 95 96 97 98 99 100 101 102 103 104 105 106 107 108 109 110 111 112 113 114 115 116 117 118 119 120 121 122 123 124 125 126 127 128 129 130 131 132 133 134 135 136 137 138 139 140 141 142 143 144 145 146 147 148 149 150 151 152 153 154 155 156 157 158 159 160 161 162 163 164 165 166 167 168 169 170 171 172 173 174 175 176 177 178 179 180 181 182 183 184 185 186 187 188 189 190 191 192 193 194 195 196 197 198 199 200 201 202 203 204 205 206 207 208 209 210 211 212 213 214 215 216 217 218 219 220 221 222 223 224 225 226 227 228 229 230 231 232 233 234 235 236 237 238 239 240 241 242 243 244 245 246 247 248 249 250 251 252 #include <sys/socket.h> #include <netinet/in.h> #include <arpa/inet.h> #include <assert.h> #include <stdio.h> #include <stdlib.h> #include <unistd.h> #include <errno.h> #include <string.h> #include <fcntl.h> #define BUFFER_SIZE 4096 enum CHECK_STATE {0 , CHECK_STATE_HEADER };enum LINE_STATUS {0 , LINE_BAD, LINE_OPEN };enum HTTP_CODE { FORBIDDEN_REQUEST, INTERNAL_ERROR, CLOSED_CONNECTION }; static const char *szret[] = { "I get a correct result\n" , "Something wrong\n" };LINE_STATUS parse_line ( char *buffer, int &checked_index, int &read_index ) { char temp; for ( ; checked_index < read_index; ++checked_index ) { temp = buffer[checked_index]; if ( temp == '\r' ) { if ( ( checked_index + 1 ) == read_index ) { return LINE_OPEN; } else if ( buffer[checked_index+1 ] == '\n' ) { buffer[checked_index++] = '\0' ; bffer[checked_index++] = '\0' ; return LINE_OK; } return LINE_BAD; } else if ( temp == '\n' ) { if ( (checked_index > 1 ) && buffer[checked_index-1 ] == 'r' ) { buffer[checked_index-1 ] = '\0' ; buffer[checked_index++] = '\0' ; return LINE_OK; } return LINE_BAD; } } return LINE_OPEN; } HTTP_CODE parse_requestline ( char *temp, CHECK_STATE &checkstate) { char *url = strpbrk ( temp, " \t" ); if ( !url ) { return BAD_REQUEST; } *url++ = '\0' ; char *method = temp; if ( strcasecmp( method, "GET" ) == 0 ) { printf ( "The requese method is GET\n" ); } else { return BAD_REQUEST; } url+= strspn ( url, " \t" ) ; char *version = strpbrk ( url, " \t" ); if ( !version ) { return BAD_REQUEST; } *version++ = '\0' ; version += strspn ( version, " \t" ); if ( strcasecmp( version, "HTTP/1.1" ) != 0 ) { return BAD_REQUEST; } if ( strncasecmp( url, "http://" , 7 ) == 0 ) { url += 7 ; url = strchr ( url, '/' ); } if ( !url || url[0 ] != '/' ) { return BAD_REQUEST; } printf ( "The request URL is : %s\n" , url ); checkstate = CHECK_STATE_HEADER; return NO_REQUEST; } HTTP_CODE parse_header ( char *temp ) { if ( temp[0 ] == '\0' ) { return GET_REQUEST; } else if ( strncasecmp( temp, "Host:" , 5 ) == 0 ) { temp += 5 ; temp += strspn ( temp, " \t" ); printf ( "the request host is: %s\n" , temp ); } else { printf ( "I can't handle this header\n" ); } return NO_REQUEST; } HTTP_CODE parse_content ( char *buffer, int &checked_index, CHECK_STATE &checkstate, int &read_index, int &start_line ) { LINE_STATUS linestatus = LINE_OK; HTTP_CODE retcode = NO_REQUEST; while ( (linestatus = parse_line( buffer, checked_index, read_index)) == LINE_OK ) { char *temp = buffer + start_line; start_line = checked_index; switch ( checkstate ) { case CHECK_STATE_REQUESTLINE: { retcode = parse_requestline( temp, checkstate ); if ( retcode == BAD_REQUEST ) { return BAD_REQUEST; } break ; } case CHECK_STATE: { retcode = parse_header( temp ); if ( retcode == BAD_REQUEST ) { return BAD_REQUEST; } else if ( retcode == GET_REQUEST ) { return GET_REQUEST; } break ; } default : { return INTERNAL_ERROR; } } } if ( linestatus == LINE_OPEN ) { return NO_REQUEST; } else { return BAD_REQUEST; } } int main ( int argc, char *argv[] ) { if ( argc <= 2 ) { printf ( "usage: ... \n" ); return 1 ; } const char *ip = argv[1 ]; int port = atoi( argv[2 ] ); struct sockaddr_in address ; bzero( &address, sizeof ( address ) ); address.sin_family = AF_INET; address.sin_port = htons( port ); inet_pton( AF_INET, ip, &address.sin_addr ); int listenfd = socket( AF_INET, SOCK_STREAM, 0 ); assert( listenfd >= 0 ); int ret = bind( listenfd, (struct sockaddr*)&address, sizeof ( address ) ); assert( ret != -1 ); ret = listen( listenfd, 5 ); assert( ret != -1 ); struct sockaddr_in client ; socklen_t client_len = sizeof ( client ); int fd = accept( listenfd, (struct sockaddr*)&client, &client_len ); if ( fd < 0 ) { printf ( "errno is: %d\n" , errno ); } else { char buffer[BUFFER_SIZE]; memset ( buffer, '\0' , BUFFER_SIZE ); int data_read = 0 ; int read_index = 0 ; int checked_index = 0 ; int start_line = 0 ; CHECK_STATE checkstate = CHECK_STATE_REQUESTLINE; while (1 ) { data_read = recv( fd, buffer+read_index, BUFFER_SIZE-read_index, 0 ); if ( data_read == -1 ) { printf ( "reading failed\n" ); break ; } else if ( data_read == 0 ) { printf ( "remote clinet has closed the connection\n" ); break ; } read_index += data_read; HTTP_CODE result = parse_content( buffer, checked_index, checkstate, read_index, start_line ); if ( reulst == NO_REQUEST ) { continue ; } else if ( result == GET_REQUEST ) { send( fd, szret[0 ], strlen ( szret[0 ] ), 0 ); break ; } else { send( fd, szret[1 ], strlen ( szret[1 ]), 0 ); break ; } } close( fd ); } close( listenfd ); return 0 ; }

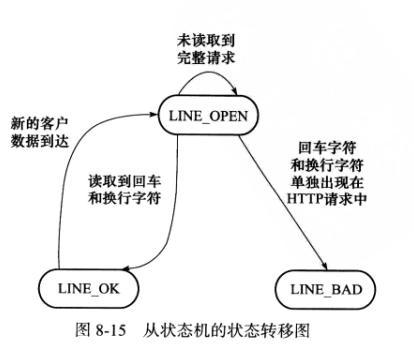

该代码中的两个有限状态机分别称为主状态机和从状态机,它们之间的关系:主状态机在内部调用从状态机。从状态机的状态及状态转移过程如下:

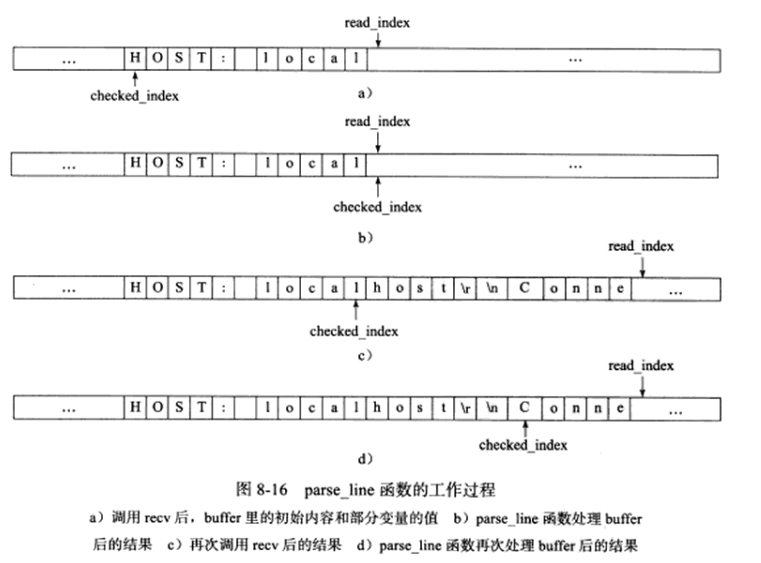

简单来说,该状态机的工作流程,recv收到数据后,调用parse_content函数(主状态机)来分析读入的数据,parse函数首先调用parse_line函数(从状态机)来获取一个完整的行。parseline函数的工作流程,如下图所示:

8.7 提高服务器性能的其他建议 讨论从编程的角度来确保服务器的性能。

a) 池

假设在服务器的硬件资源充分的情况下,提高服务器性能的一个直接的方式即是空间换时间,即”浪费”服务器的硬件资源,以换取其运行效率。这就是池的概念。简单来说,池就是将一些需要用到的资源提前分配创建好,用的时候直接从其中取资源比动态分配资源的速度要快得多,处理完后,将资源放回池中。

根据不同的资源类型,池可分为多种,常见的有内存池,进程池,线程池和连接池。

内存池通常用于socket的接受缓存和发送缓存。预先分配一个大小足够的缓冲区。

线程池和进程池,当我们需要一个工作进程/线程来处理客户请求时,可直接从池中取一个实体,而无需调用fork或pthread_create来创建。

连接池通常用于服务器或服务器集群的内部永久连接。

b) 上下文切换和锁

并发程序必须考虑上下文切换问题,即进程切换或线程切换导致的系统开销。即使是I/O密集型的服务器,也不应该使用过多的工作线程,否则线程间的切换将占用大量的CPU时间。因此,为每个客户连接都创建一个工作线程的服务器是不可取的。图8-11的模式是一种比较合理的解决方案。

另一个问题是对共享资源的加锁保护。锁通常被认为是导致服务器效率低下的一个因素,因为它引入的代码不处理任何业务逻辑,而且需要访问内核资源。如果服务器必须使用锁,考虑减小锁的粒度,比如使用读写锁。当所有工作线程都只读取一块共享内存的内容时,读写锁并不会增加额外的开销,只有当其中一个工作线程需要写这块内存时,才去上锁。

c) 数据复制

高性能服务器应该避免不必要的数据复制,尤其是当数据复制发生在用户和内核之间。比如ftp服务器,无需把目标文件的内容完整地读入到应用程序缓冲区中并调用send函数发送,而是可用”零拷贝”的sendfile函数直接发送。

此外,用户代码内部的数据复制也是应该避免的。比如,两个工作进程之间需要传递大量的数时,我们应该考虑使用共享内存在他们之间直接共享这些数据,而不是使用管道或消息队列来传递。

第9章 I/O复用 I/O复用使得程序能同时监听多个文件描述符,通常网络程序在下列情况下需要使用I/O复用功能:

客户端程序要同时处理多个socket。比如本章将讨论的非阻塞connect。

客户端程序要同时处理用户输入和网络连接。比如本章讨论的聊天室程序。

TCP服务器要同时处理监听socket和连接socket。

服务器要同时处理TCP请求和UDP请求。比如本章讨论的回射服务器。

服务器要同时监听多个端口,或者处理多种服务器。比如本章讨论的xinetd服务器。

Linux下实现I/O复用的系统调用主要有select,poll和epoll。

9.1 select系统调用 a) selectAPI

select系统调用的原型如下:

1 2 3 #include <sys/select.h> int select (int nfds, fd_set *readfds, fd_set *writefds, fd_set *exceptfds, struct timeval *timeout) ;

nfds参数指定被监听的文件描述符总数,通常被设置为select监听的所有描述符中的最大值加以。

readfds,exceptfds,writefds分别指向可读,异常和可写对应的文件描述符集合。fd_set结构如下:

1 2 3 4 5 6 7 8 9 10 11 12 13 14 15 16 17 #include <typesizes.h> #define __fD_SETSIZE 1024 #include <sys/select.h> #define FD_SETSIZE __FD_SETSIZE typedef long in __fd_mask;#undef __NFDBITS #define __NFDBITS ( 8 * (int) sizeof (__fd_mask ) ) typedef struct {#ifdef __USE_XOPEN __fd_mask fds_bits[ __FD_SETSIZE / __NFDBITS ]; #define __FDS_BITS(set) ((set)->fds_bits) #else __Fd_mask __fds_bits[ __FD_SETSIZE / __NFDBITS ]; #define __FDS_BITS(set) ((set)->__fds_bits) #endif } fd_set;

使用如下一系列宏来访问fd_set结构体中的位:

1 2 3 4 5 #include <sys/select.h> FD_ZERO(fd_set *fdset); FD_SET(int fd, fd_set *fdset); FD_CLR(int fd, fd_set *fdset); int FD_ISSET (int fd, fd_set *fdset) ;

timeout参数设置超时时间:

1 2 3 4 struct timeval { long tv_sec; long tv_usec; };

select成功时返回就绪文件描述符的总数。

b) 文件描述符就绪条件

在网络编程中,下列情况下socket可读:

socket内核接受缓存区中的字节数大于或等于其低水位标记SO_RCVLOWAT。此时可以无阻塞地读该socket,且读操作返回的字节数大于0。

socket通信的对方关闭连接。此时读操作返回0。

监听socket上有新的连接请求。

socket上有未处理的错误。此时可以用getsockopt来读取和清除该错误。

下列情况下socket可写:

socket内核发送缓存区中的可用字节数大于或等于其低水位标记SO_SNDLOWAT。此时可用无阻塞的写该socket,且写操作的字节数大于0。

socket的写操作被关闭。对写操作被关闭的socket执行写操作将触发一个SIGPIPE信号。

socket使用非阻塞connect连接成功或者失败之后。

socket上有未处理的错误。此时可以用getsockopt来读取和清除该错误。

网络程序中,select能处理的异常情况只有一种:socket上接收到带外数据。下节将详细讨论。

c) 处理带外数据

1 2 3 4 5 6 7 8 9 10 11 12 13 14 15 16 17 18 19 20 21 22 23 24 25 26 27 28 29 30 31 32 33 34 35 36 37 38 39 40 41 42 43 44 45 46 47 48 49 50 51 52 53 54 55 56 57 58 59 60 61 62 63 64 65 66 67 68 69 70 71 72 73 74 75 76 77 78 79 80 81 82 83 //同时接受普通数据和带外数据 #include <sys/types.h> #include <sys/socket.h> #include <netinet/in.h> #include <arpa/inet.h> #include <assert.h> #include <stdio.h> #include <unistd.h> #include <errno.h> #include <string.h> #include <fcntl.h> #include <stdlib.h> int main( int argc, char *argv[] ) { if ( argc <= 2 ) { printf( "usage: ... " ); return 1; } const char *ip = argv[1]; int port = atoi( argv[2] ); int ret = 0; struct sockaddr_in address; bzero( &address, sizeof( address ) ); address.sin_family = AF_INET; address.sin_port = htons( port ); inet_pton( AF_INET, ip, &address.sin_addr ); int listenfd = socket( AF_INET, SOCK_STREAM, 0 ); assert( listenfd >= 0 ); ret = bind( listenfd, (struct sockaddr*)&address, sizeof( address ) ); assert( ret != -1 ); ret = listen( listenfd, 5 ); assert( ret != -1 ); struct sockaddr client; socklen_t client_len = sizeof( client ); int connfd = accept( listenfd, (struct sockaddr*)&clinet, &client_len ); if ( connfd < 0 ) { printf( "errno is %d\n", errno ); close( listenfd ); } char buf[1024]; fd_set read_fds; fd_set exception_fds; FD_ZERO( &read_fds ); FD_ZERO( &exception_fds ); while (1) { memset( buf, '\0', sizeof(buf) ); //每次调用select前都需要重新在read_fds和exception_fds中设置文件描述符 FD_SET( connfd, &read_fds ); FD_SET( connfd, &exception_fds ); ret = select( connfd+1, &read_fds, NULL, &exception_fds, NULL ); if ( ret < 0 ) { printf( "selection failure\n" ); break; } //对于可读事件,采用普通的recv函数读取数据 if ( FD_ISSET( connfd, &read_fds ) ) { ret = recv( connfd, buf, sizeof(buf)-1, 0 ); if (ret <= 0) { break; } printf( "get %d bytes of normal data: %s\n", ret, buf ); } //对于异常事件,采用带MSG_OBB标志的recv函数读取带外数据 else if ( FD_ISSET( connfd, &exception_fds ) ) { ret = recv( connfd, buf, sizeof(buf)-1. MSG_OBB ); if ( ret <= 0 ) { break; } printf( "get %d bytes of obb data: %s\n", ret, buf ); } } close( connfd ); close( listenfd ); return 0; }

9.2 poll系统调用 poll系统调用与selec类似,也是指定时间内轮询一定数量的文件描述符:

1 2 #include <poll.h> int poll (struct pollfd *fds, nfds_t nfds, int timeout) ;

pollfd参数即select三种事件集合的综合,采用一个结构体,定义如下:

1 2 3 4 5 struct pollfd { int fd; short events; short revents; };

fd指定文件描述符,evets成员告诉poll监听fd上的哪些事件,它是一系列的按位或,revetns由内核修改,通知应用程序fd上实际发生了哪些事件。poll支持的事件类型如下表:

事件

描述

是否可作为输入

是否可作为输出

POLLIN

数据(包括普通数据和优先数据)可读

是

是

POLLRDNORM

普通数据可读

是

是

POLLRDBAND

优先级带数据可读(Linux不支持)

是

是

POLLPRI

高优先级数据可读,比如TCP带外数据

是

是

POLLOUT

数据(包括普通数据和优先数据)可写

是

是

POLLWRNORM

普通数据可写

是

是

POLLWRBAND

优先级带数据可写

是

是

POLLRDHUP

TCP连接被对方关闭,或者对方关闭了写操作。他由GUN引入

是

是

POLLER

错误

否

是

POLLHUP

挂起。比如管道的写端被关闭后,读描述上将收到POLLHUP事件

否

是

POLLNVAL

文件描述符没有打开

否

是

nfds参数指定被监听事件集合的fds的大小

timeout参数指定超时值

9.3 epoll系列系统调用 a) 内核事件表

epoll把用户关心的文件描述符上的事件放在内核的一个事件表中,从而无需像select和poll那样每次调用都要重复传入文件描述符集或事件集。但epoll需要一个额外的文件描述符,来唯一标识内核中的这个事件表,该文件描述符使用如下函数创建:

1 2 #include <sys/epoll.h> int epoll_create (int size) ;

size参数现在不起作用,仅作为给内核的一个提示,告诉他事件表需要多大。该函数返回的文件描述符将所用与其他epoll系统调用的第一个参数,以指定要访问的内核事件表。

下面的函数用来操作epoll的内核事件表:

1 2 #include <sys/epoll.h> int epoll_ctl (int epfd, int op, int fd, struct epoll_event *evnet) ;

fd参数为操作的描述符,op参数指定操作类型,类型如下三种:

EPOLL_CTL_ADD,往事件表中注册fd上的事件。

EPOLL_CTL_MOD,修改fd上的注册事件。

EPOLL_CTL_DEL,删除fd上的注册事件。

event参数指定事件,它是epoll_event结构指针类型。定义如下:

1 2 3 4 struct epoll_event { __uint32_t events; epoll_data_t data; };

data成员用于存储用户数据,其类型定义如下:

1 2 3 4 5 6 typedef union epoll_data { void *ptr; int fd; uint32_t u32; uint64_t u64; } epoll_data_t ;

b) epoll_wait函数

epoll系列系统调用的主要接口函数:

1 2 #include <sys/epoll.h> int epoll_wait (int epfd, struct epoll_event *evetns, int maxevents, int timeout) ;

epoll_wait函数如果检测到事件,就将所有就绪的事件从内核事件表中复制到它的第二个参数events指向的数组中。这个数组只用于输出epoll_wait检测到的就绪事件,而不像select和Poll既用于传入,又用于输出。

1 2 3 4 5 6 7 8 9 10 11 12 13 14 15 16 17 18 19 int ret = poll(fds, MAX_EVENT_NUMBER, -1 );for (int i = 0 ; i<MAX_EVENT_NUMBER; ++i) { if (fds[i].revents & ) { int sockfd = fds[i],fd; } } int ret = epoll_wait(epollfd, evetns, MAX_EVENT_NUMBER, -1 );for (int i = 0 ; i<ret; i++) { int sockfd = evetns[i].data.fd; }

c) LT和ET模式

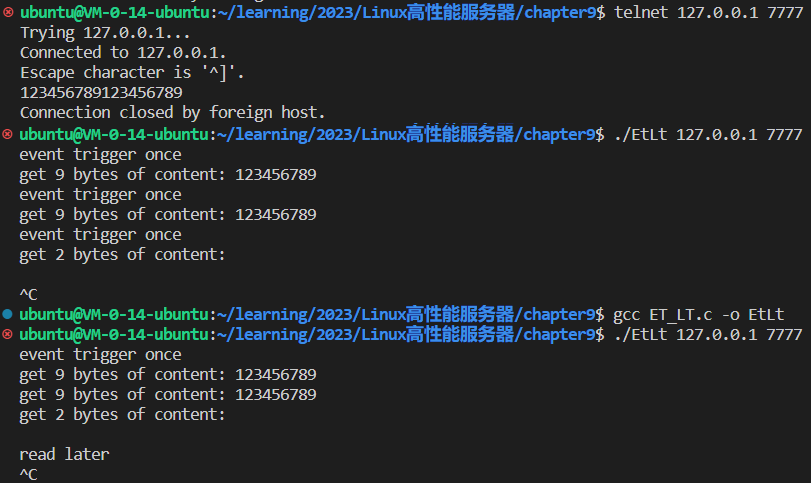

epoll对文件描述符的操作有两种模式: LT (Level Trigger, 电平触发)模式和 ET(Edge Trigger, 边沿触发)模式。LT模式是默认的工作模式,这种模式相当于一个效率较高的poll。当注册事件EPOLLET时,epoll将以ET模式来操作,ET模式是epoll的高效工作模式。

LT:epoll_wait检测到其上有事件发生并将此事件通知应用程序后,应用程序可以不立即处理该事件。这样,下次调用epoll_wait时,epoll_wait还会再次向应用程序通告此事件,直到该事件被处理。

ET:应用程序必须立即处理,因为后续的epoll_wait调用将不再向应用程序通知这一事件。

1 2 3 4 5 6 7 8 9 10 11 12 13 14 15 16 17 18 19 20 21 22 23 24 25 26 27 28 29 30 31 32 33 34 35 36 37 38 39 40 41 42 43 44 45 46 47 48 49 50 51 52 53 54 55 56 57 58 59 60 61 62 63 64 65 66 67 68 69 70 71 72 73 74 75 76 77 78 79 80 81 82 83 84 85 86 87 88 89 90 91 92 93 94 95 96 97 98 99 100 101 102 103 104 105 106 107 108 109 110 111 112 113 114 115 116 117 118 119 120 121 122 123 124 125 126 127 128 129 130 131 132 133 134 135 136 137 138 139 140 141 142 143 144 145 146 147 148 149 150 151 152 153 154 155 156 157 158 159 160 161 162 #include <sys/types.h> #include <sys/socket.h> #include <netinet/in.h> #include <arpa/inet.h> #include <assert.h> #include <unistd.h> #include <stdio.h> #include <errno.h> #include <fcntl.h> #include <stdlib.h> #include <string.h> #include <sys/epoll.h> #include <sys/types.h> #include <pthread.h> #define MAX_EVENT_NUMBER 1024 #define BUFFER_SIZE 10 #define true 1 #define false 0 typedef int bool ;int setnonblocking (int fd) { int old_option = fcntl(fd, F_GETFL); int new_option = old_option | O_NONBLOCK; fcntl(fd, F_SETFL, new_option); return old_option; } void addfd (int epollfd, int fd, bool enable_et) { struct epoll_event event ; event.data.fd = fd; event.events = EPOLLIN; if (enable_et) { event.events |= EPOLLET; } epoll_ctl(epollfd, EPOLL_CTL_ADD, fd, &event); setnonblocking(fd); } void Lt (struct epoll_event *events, int number, int epollfd, int listenfd) { char buf[BUFFER_SIZE]; for (int i=0 ; i<number; i++) { int sockfd = events[i].data.fd; if (sockfd == listenfd) { struct sockaddr_in client_address ; socklen_t client_addrlen = sizeof (client_address); int connfd = accept(listenfd, (struct sockaddr*)&client_address, &client_addrlen); addfd(epollfd, connfd, false ); } else if (events[i].events & EPOLLIN) { printf ("event trigger once\n" ); memset (buf, '\0' , BUFFER_SIZE); int ret = recv(sockfd, buf, BUFFER_SIZE-1 , 0 ); if (ret <= 0 ) { close(sockfd); continue ; } printf ("get %d bytes of content: %s\n" , ret ,buf); } else { printf ("something else happend\n" ); } } } void Et (struct epoll_event* events, int number, int epollfd, int listenfd) { char buf[BUFFER_SIZE]; for (int i=0 ; i<number; i++) { int sockfd = events[i].data.fd; if (sockfd == listenfd) { struct sockaddr_in client_address ; socklen_t client_addrlen = sizeof (client_address); int connfd = accept(listenfd, (struct sockaddr*)&client_address, &client_addrlen); addfd(epollfd, connfd, true ); } else if (events[i].events & EPOLLIN) { printf ("event trigger once\n" ); while (1 ) { memset (buf, '\0' , BUFFER_SIZE); int ret = recv(sockfd, buf, BUFFER_SIZE-1 , 0 ); if (ret < 0 ) { if ((errno == EAGAIN) || (errno == EWOULDBLOCK)) { printf ("read later\n" ); break ; } close(sockfd); break ; } else if (ret == 0 ) { close(sockfd); } else { printf ("get %d bytes of content: %s\n" , ret, buf); } } } else { printf ("something else happend\n" ); } } } int main (int argc, char *argv[]) { if (argc <= 2 ) { printf ("usage: ip_address port_number\n" ); return 1 ; } const char *ip = argv[1 ]; int port = atoi(argv[2 ]); int ret = 0 ; struct sockaddr_in address ; bzero(&address, sizeof (address)); address.sin_family = AF_INET; address.sin_port = htons(port); inet_pton(AF_INET, ip, &address.sin_addr); int listenfd = socket(AF_INET, SOCK_STREAM, 0 ); assert(listenfd >= 0 ); int opt = 1 ; setsockopt(listenfd, SOL_SOCKET, SO_REUSEADDR, &opt, sizeof (opt)); ret = bind(listenfd, (struct sockaddr*)&address, sizeof (address)); assert(ret != -1 ); ret = listen(listenfd, 5 ); assert(ret != -1 ); struct epoll_event events [MAX_EVENT_NUMBER ]; int epollfd = epoll_create(5 ); assert(epollfd != -1 ); addfd(epollfd, listenfd, true ); while (1 ) { int ret = epoll_wait(epollfd, events, MAX_EVENT_NUMBER, -1 ); if (ret < 0 ) { printf ("epolll failure\n" ); break ; } Et(events, ret, epollfd, listenfd); } close(listenfd); return 0 ; }

d) EPOLLONESHOT事件

即使我们使用ET模式,一个socket上的某个事件还是可能被多次触发。在并发中这会导致一个问题,比如一个线程读完某个socket上的数据开始处理这些数据,而在数据处理过程中,socket上又有新数据可读,EPOLLIN再次触发,此时另一个线程被唤醒来读取这些数据。导致出现了两个线程同时操作一个socket的局面。使用epoll的EPOLLONESHOT事件解决该情况。

对于注册了EPOLLONESHOT事件的文件描述符,操作系统最多触发其上注册的一个可读,可写或异常事件,且只触发一次,除非我们使用epoll_ctl函数重置该文件描述符上注册的EPOLLONESHOT事件。

有点像上锁(。

1 2 3 4 5 6 7 8 9 10 11 12 13 14 15 16 17 18 19 20 21 22 23 24 25 26 27 28 29 30 31 32 33 34 35 36 37 38 39 40 41 42 43 44 45 46 47 48 49 50 51 52 53 54 55 56 57 58 59 60 61 62 63 64 65 66 67 68 69 70 71 72 73 74 75 76 77 78 79 80 81 82 83 84 85 86 87 88 89 90 91 92 93 94 95 96 97 98 99 100 101 102 103 104 105 106 107 108 109 110 111 112 113 114 115 116 117 118 119 120 121 122 123 124 125 126 127 128 129 130 131 132 133 134 135 136 137 138 139 140 141 142 143 144 145 146 147 148 149 150 151 152 153 154 155 #include <sys/types.h> #include <sys/socket.h> #include <netinet/in.h> #include <arpa/inet.h> #include <assert.h> #include <stdio.h> #include <unistd.h> #include <errno.h> #include <string.h> #include <fcntl.h> #include <stdlib.h> #include <sys/epoll.h> #include <pthread.h> #define MAX_EVENT_NUMBER 1024 #define BUFFER_SIZE 1024 #define true 1 #define false 0 typedef int bool ;struct fds { int epollfd; int sockfd; }; int setnonblocking (int fd) { int old_option = fcntl(fd, F_GETFL); int new_option = old_option | O_NONBLOCK; fcntl(fd, F_SETFL, new_option); return old_option; } void addfd (int epollfd, int fd, bool oneshot) { struct epoll_event event ; event.data.fd = fd; event.events = EPOLLIN | EPOLLET; if (oneshot) { event.events |= EPOLLONESHOT; } epoll_ctl(epollfd, EPOLL_CTL_ADD, fd, &event); setnonblocking(fd); } void reset_oneshot (int epollfd, int fd) { struct epoll_event event ; event.data.fd = fd; event.events = EPOLLIN | EPOLLET | EPOLLONESHOT; epoll_ctl(epollfd, EPOLL_CTL_ADD, fd, &event); } void *worker (void *arg) { int sockfd = ((fds*)arg)->sockfd; int epollfd = ((fds*)arg)->epollfd; printf ("start new thread to receive data on fd: %d\n" , sockfd); char buf[BUFFER_SIZE]; memset (buf, '\0' , BUFFER_SIZE); while (1 ) { int ret = recv(sockfd, buf, BUFFER_SIZE-1 , 0 ); if (ret == 0 ) { close(sockfd); printf ("foreinter closed the connection\n" ); break ; } else if (ret < 0 ) { if (errno == EAGAIN) { reset_oneshot(epollfd, sockfd); printf ("read later\n" ); break ; } } else { printf ("get content: %s\n" , buf); sleep(5 ); } } printf ("end thread receiving data on fd:\n" , sockfd); } int main (int argc, char *argv[]) { if (argc <= 2 ) { printf ("usage: error\n" ); return 1 ; } const char *ip = argv[1 ]; int port = atoi(argv[2 ]); int ret = 0 ; struct sockaddr_in address ; bzero(&address, sizeof (address)); address.sin_family = AF_INET; address.sin_port = htons(port); inet_pton(AF_INET, ip, &address.sin_addr); int listenfd = socket(AF_INET, SOCK_STREAM, 0 ); assert(listenfd >= 0 ); int opt = 1 ; setsockopt(listenfd, SOL_SOCKET, SO_REUSEADDR, &opt, sizeof (opt)); ret = bind(listenfd, (struct sockaddr*)&address, sizeof (address)); assert(ret != -1 ); ret = listen(listenfd, 5 ); assert(ret != -1 ); strcut epoll_event events[MAX_EVENT_NUMBER]; int epollfd = epoll_create(5 ); assert(epollfd != -1 ); addfd(epollfd, listenfd, false ); while (1 ) { int ret = epoll_wait(epollfd, events, MAX_EVENT_NUMBER, -1 ); if (ret < 0 ) { printf ("epoll failure\n" ); break ; } for (int i = 0 ; i<ret; i++) { int sockfd = events[i].data.fd; if (sockfd == listenfd) { struct sockaddr_in client_address ; socklen_t client_addrlen = sizeof (client_address); int connfd = accept(listenfd, (struct sockaddr*)&client_address, &client_addrlen); addfd(epollfd, connfd, true ); } else if (events[i].events & EPOLLIN) { pthread_t thread; fds fds_for_new_worker; fds_for_new_worker.epollfd = epollfd; fds_for_new_worker.sockfd = sockfd; pthread_create(&thread, NULL , worker, (void *)&fds_for_new_worker); } else { printf ("something else happend\n" ); } } } close(listenfd); return 0 ; }

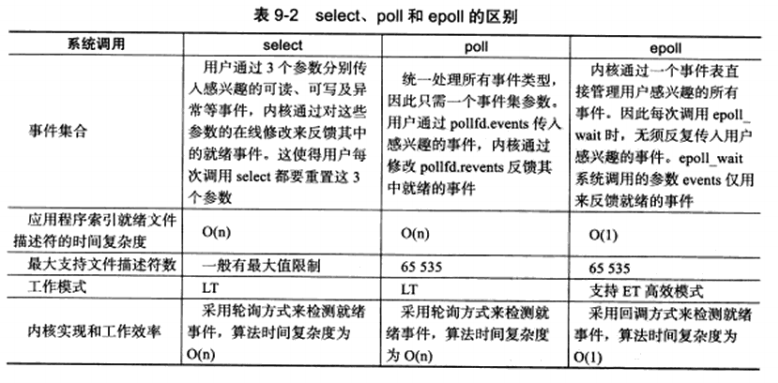

9.4 三组I/O复用函数的比较 事件集合不同,select通过三个事件集来监听,并且内核通过对其的修改来反馈结果,所以每次调用都需要重置这3个参数,poll将三个统一为一个,将输入和输出分为event和revent分离,epoll则内核将输出传出,无需反复传入用户需要监听的事件。

工作模式,select和poll只支持LT模式,epoll支持ET和LT。

内核实现和效率,select和poll采用轮询方式检测就绪事件,时间复杂度O(n);epoll通过回调方式来检测,时间复杂度O(1)。

9.5 I/O复用的高级应用一: 非阻塞connect

上述文描述了connect出错时的一种errno值:EINPROGRESS。这种错误发生在对非阻塞的socket调用connect,而连接又没有立即建立时。在这种情况下,可以调用select,poll等函数来监听这个连接失败的socket上的可写事件。当select,poll函数返回后,再利用getsockopt来读取错误码并清除该socket上的错误。如果错误码是0表示连接建立成功。

1 2 3 4 5 6 7 8 9 10 11 12 13 14 15 16 17 18 19 20 21 22 23 24 25 26 27 28 29 30 31 32 33 34 35 36 37 38 39 40 41 42 43 44 45 46 47 48 49 50 51 52 53 54 55 56 57 58 59 60 61 62 63 64 65 66 67 68 69 70 71 72 73 74 75 76 77 78 79 80 81 82 83 84 85 86 87 88 89 90 91 92 93 94 95 96 97 98 99 100 101 102 103 104 105 106 107 108 109 110 111 112 #include <sys/types.h> #include <sys/socket.h> #include <netinet/in.h> #include <arpa/inet.h> #include <assert.h> #include <stdio.h> #include <stdlib.h> #include <time.h> #include <errno.h> #include <fcntl.h> #include <unistd.h> #include <sys/ioctl.h> #include <string.h> #define BUFFER_SIZE 1023 int setnonblocking (int fd) { int old_option = fcntl(fd, F_GETFL); int new_option = old_option | O_NONBLOCK; fcntl(fd, F_SETFL, new_option); return old_option; } int unblock_connect (const char *ip, int port, int time) { int ret = 0 ; struct sockaddr_in address ; bzero(&address, sizeof (address)); address.sin_family = AF_INET; address.sin_port = htons(port); inet_pton(AF_INET, ip, &address.sin_addr); int sockfd = socket(AF_INET, SOCK_STREAM, 0 ); int fdopt = setnonblocking(sockfd); ret = connect(sockfd, (struct sockaddr*)&address, sizeof (address)); if (ret == 0 ) { printf ("connect with server immediately\n" ); fcntl(sockfd, F_SETFL, fdopt); return sockfd; } else if (errno != EINPROGRESS) { printf ("unblock connect not support\n" ); return -1 ; } fd_set readfds; fd_set writefds; struct timeval timeout ; FD_ZERO(&readfds); FD_SET(sockfd, &writefds); timeout.tv_sec = time; timeout.tv_usec = 0 ; ret = select(sockfd+1 , NULL , &writefds, NULL , &timeout); if (ret <= 0 ) { printf ("connection time out\n" ); close(sockfd); return -1 ; } if (!FD_ISSET(sockfd, &writefds)) { printf ("no event on sockfd found\n" ); close(sockfd); return -1 ; } int error = 0 ; socklen_t length = sizeof (error); if (getsockopt(sockfd, SOL_SOCKET, SO_ERROR, &error, &legnth) < 0 ) { printf ("get socket option failed\n" ); close(sockfd); return -1 ; } if (error != 0 ) { printf ("connection failed afeter select with the error: %d\n" , error); close(sockfd); return -1 ; } printf ("connection ready after select with the socket: %d\n" , sockfd); fcntl(sockfd, F_SETFL, fdopt); return sockfd; } int main (int argc, char *argv[]) { if (argc <= 2 ) { printf ("usage: error\n" ); return 1 ; } const char *ip = argv[1 ]; int port = atoi(argv[2 ]); int sockfd = unblock_connect(ip, port, 10 ); if (sockfd < 0 ) { return 1 ; } close(sockfd); return 0 ; }

但该方法存在移植性问题。首先,非阻塞的socket可能导致connect失败。其次select对处于EINPROGRESS状态下的socket可能不起作用。以及,出错的socket,getsockopt返回值不一,有的为-1,有的为0。

9.6 I/O复用的高级应用二: 聊天室程序 以poll实现一个简单的聊天室程序。阐述如何使用I/O复用技术来同时处理网络连接和用户输入。它分为客户端和服务端两个部分。

客户端:一是从标准输入终端读入用户数据,并将用户数据发送至服务器;二是往标准输出终端打印服务器发送给它的数据。

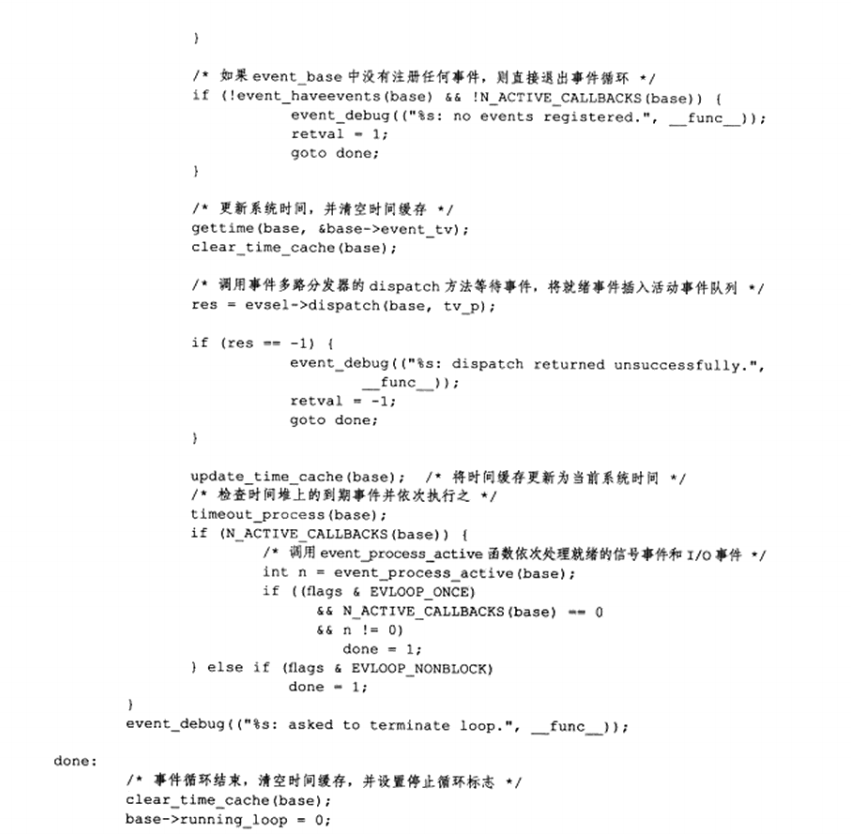

服务器:接受用户数据,并把客户数据发送给每一个登录到该服务器上的客户端,数据发送者除外。